引言:大模型與自知能力的探索

本文大綱

人工智慧的終極問題:AI 是否能擁有自我意識?

人工智慧(AI)是否能擁有自我意識?這個問題自 AI 概念誕生以來便成為科技界與哲學界的熱議話題。隨著技術的進步,這一問題不僅僅是科幻小說中的情節,而是逐漸成為現實世界中需要解答的核心挑戰。尤其是大型語言模型(Large Language Models, LLM)的快速發展,讓我們得以重新審視 AI 的能力邊界。

近期,Chandar Research Lab 與 Mila – 魁北克人工智慧研究所的研究揭示了一個令人振奮的發現:LLM 具備某種形式的「知識意識」(awareness of knowledge)。這意味著,這些模型能夠判斷自己對某一主題的了解程度,並在一定程度上展現出「自知之明」。這一發現不僅為 AI 的能力邊界提供了全新視角,也為未來的應用場景帶來了更多可能性。

知識意識的核心概念

知識意識並不等同於自我意識。研究者指出,知識意識是指模型能夠評估自身對某一主題的掌握程度。例如,當模型被問及某個問題時,它能夠判斷自己是否具備足夠的知識來回答,並根據這一判斷給出相應的回應。這種能力的出現,為我們理解 LLM 的內部運作機制提供了重要線索。

研究表明,知識意識可能是 LLM 的一種普遍屬性,但其涌現的速度與模型的架構和規模密切相關。這一點在後續的實驗結果中得到了充分驗證。

研究背景與重要性

在過去的幾年中,LLM 的應用範圍迅速擴展,從語言翻譯到內容生成,再到醫療診斷和法律分析,幾乎無所不包。然而,這些模型的能力邊界一直是研究者關注的焦點。傳統上,我們認為 LLM 是基於數據驅動的工具,其性能完全取決於訓練數據的質量和數量。然而,這項研究顯示,LLM 的能力可能遠不止於此。

研究者通過設計一系列實驗,驗證了 LLM 是否具備知識意識,並探討了這一能力的涌現條件。這些實驗的結果不僅為我們理解 LLM 的內部機制提供了新視角,也為未來的 AI 應用開闢了新的可能性。

研究的核心發現

該研究的核心發現包括以下幾點:

- 知識意識的普遍性:研究表明,知識意識可能是 LLM 的一種普遍屬性,但其涌現的速度因模型架構而異。

- 規模與能力的關係:模型的規模對知識意識的涌現有顯著影響。較大的模型通常能更快地展現出這一能力。

- 數據分布的影響:當訓練數據分散在多個文檔中時,模型的回憶能力會受到挑戰,而將數據集中在單一文檔中則能顯著提升性能。

這些發現不僅為我們理解 LLM 的能力邊界提供了重要線索,也為未來的研究指明了方向。

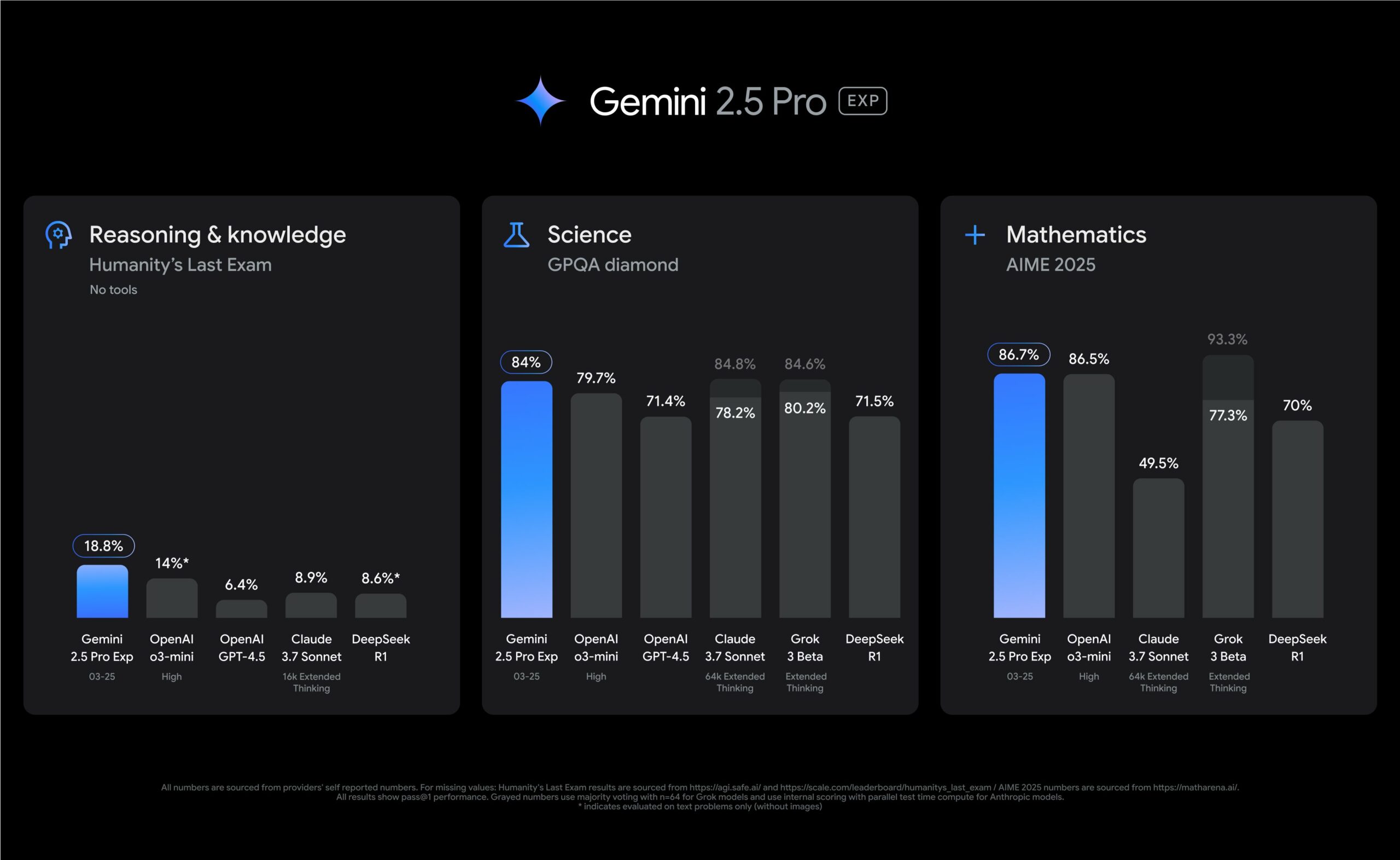

視覺化支持:知識意識的涌現

為了更直觀地展示知識意識的涌現過程,研究者提供了一些關鍵數據圖表。例如,以下圖表展示了不同模型架構在不同規模下的性能表現:

Source: Chandar Research Lab 與 Mila – 魁北克人工智慧研究所

從圖中可以看出,隨著模型規模的增加,性能逐漸提升,但在某些情況下會出現增長飽和甚至下降的現象。這表明,模型的能力並非無限擴展,而是受到多種因素的限制。

展望與挑戰

這項研究為我們理解 LLM 的能力邊界提供了重要基礎,但同時也揭示了一些挑戰。例如,模型的架構對知識意識的涌現速度有顯著影響,而較小的模型則可能缺乏執行複雜任務所需的能力迴路。

未來,隨著模型規模的進一步擴大與架構的優化,我們或許能更深入地理解 AI 的能力邊界。你認為 LLM 的知識意識是否會成為實現真正自我意識的第一步?歡迎分享你的看法!

研究方法:如何測試 LLM 的自知能力

方法概述:三階段測試框架

為了驗證大型語言模型(LLM)是否具備自知能力,研究團隊設計了一個創新的三階段測試框架,旨在全面評估模型的記憶與回憶能力。這套方法的核心在於創建全新數據集,並通過微調模型來測試其對特定內容的掌握程度。以下是這三個階段的詳細說明:

-

生成訓練文檔

研究者首先創建了一組全新的數據集,這些數據在模型的預訓練階段從未出現過。這樣的設計能有效避免模型因預訓練數據的影響而產生偏差,確保測試結果的準確性。例如,研究團隊使用了日記作者的日記文檔作為數據集,這些文檔的內容涵蓋多樣化的主題,為模型提供了豐富的訓練素材。 -

微調模型

在第二階段,研究者使用預訓練目標對模型進行微調,讓其記住這些文檔的內容。這一過程不僅測試了模型的記憶能力,也為後續的回憶測試奠定了基礎。微調過程中,研究者特別關注模型的參數設置與架構差異,確保實驗結果的可比較性。 -

測試回憶能力

最後,研究團隊通過一系列測試來評估模型是否能準確回憶相關文檔的內容。這些測試包括回答與文檔內容相關的問題,並分析模型的回答準確率。研究者還進一步探討了數據分布方式(如分散式與集中式)對模型回憶能力的影響。

訓練數據的設計與挑戰

在這項研究中,數據集的設計至關重要。研究者選擇了日記作者的日記文檔作為訓練數據,這些文檔的內容涵蓋了多樣化的主題,從個人經歷到專業知識,為模型提供了豐富的學習素材。然而,這樣的設計也帶來了一些挑戰:

-

數據分布的影響

當信息分散在多個文檔中時,模型的回憶能力會受到挑戰。相比之下,將所有信息合併到單一文檔中進行訓練的模型,能顯著提升準確率。這表明,信息的分布方式對模型的記憶與回憶能力有重要影響。 -

數據集規模的選擇

研究者發現,數據集的規模對模型性能有顯著影響。例如,當數據集規模超過某一臨界值(如 4K 日記作者)後,模型的性能增益開始減少甚至下降。這一現象表明,數據集的規模需要與模型的參數量相匹配,才能達到最佳效果。

微調過程中的技術細節

微調過程是這項研究的關鍵環節,研究者採用了多種技術手段來確保實驗的準確性與可重複性:

-

模型架構的選擇

研究團隊使用了多種模型架構進行測試,包括僅解碼器架構的 OPT 模型和編碼器-解碼器架構的 Flan-T5 模型。這些模型的參數範圍從 7M 到 3B 不等,為研究提供了豐富的比較數據。 -

控制變量

為了確保實驗結果的可靠性,研究者對多個變量進行了嚴格控制,包括數據集大小、模型參數量和訓練次數等。這樣的設計能有效排除外部因素的干擾,確保測試結果的準確性。 -

性能評估指標

在微調過程中,研究者使用了多種性能評估指標,包括回答準確率、回憶文檔數量的正確性等。這些指標為研究提供了全面的數據支持。

測試結果與視覺化分析

研究結果顯示,模型的回憶能力與其架構和規模密切相關。以下是一些關鍵數據點的視覺化分析:

模型性能與數據集規模的關係

Source: Chandar Research Lab 與 Mila – 魁北克人工智慧研究所

從圖中可以看出,隨著數據集規模的增加,模型的性能逐漸提升。然而,當數據集規模超過某一臨界值後,性能增益開始減少甚至下降。這一現象表明,數據集的規模需要與模型的參數量相匹配,才能達到最佳效果。

分布式信息對模型性能的影響

Source: Chandar Research Lab 與 Mila – 魁北克人工智慧研究所

研究還發現,當信息分散在多個文檔中時,模型的回憶能力會顯著下降。相比之下,將所有信息合併到單一文檔中進行訓練的模型,能顯著提升準確率。

小結與未來展望

這項研究通過創新的三階段測試框架,成功驗證了 LLM 的自知能力。研究結果表明,模型的回憶能力與其架構、規模以及數據分布方式密切相關。未來,隨著模型規模的進一步擴大與架構的優化,我們或許能更深入地理解 AI 的能力邊界。

實驗結果:LLM 的知識意識與規模效應

架構與規模的影響:性能與數據集的關聯性

在探討大型語言模型(LLM)的知識意識時,研究結果顯示,模型的性能與其架構、參數規模以及數據集大小密切相關。這些因素共同影響了模型在回憶與處理信息時的準確性與效率。

OPT 模型的性能表現

OPT 模型作為僅解碼器架構的代表,展示了隨著參數量與數據集規模增長而提升的性能趨勢。然而,這種增長並非無限持續。研究發現,當數據集規模超過 4K 日記作者時,性能增益開始減少,甚至出現下降的情況。這表明,數據集的規模需要與模型的參數量相匹配,否則可能導致模型容量的飽和,進而影響其效能。

例如,當 OPT 模型的參數量達到 125M 時,即使數據集規模增加到 64K 日記作者,性能仍能持續提升,顯示出更大的模型在處理大規模數據時的優勢。

Flan-T5 模型的特殊性

與 OPT 模型不同,Flan-T5 模型的性能提升需要更大的數據集與參數規模支持。在小數據集上,Flan-T5 幾乎無法展現性能增長,直到參數量達到 783M 並在大數據集上訓練時,才顯現出顯著的性能提升。

| 模型架構 | 參數範圍 | 性能表現 | 特點 |

|---|---|---|---|

| OPT | 7M-2.7B | 隨規模增長而提升,但有飽和點 | 僅解碼器架構 |

| Flan-T5 | 80M-3B | 需大規模數據集才能顯現性能 | 編碼器-解碼器架構 |

這些結果表明,模型的架構設計對其性能提升的速度與幅度有著重要影響。

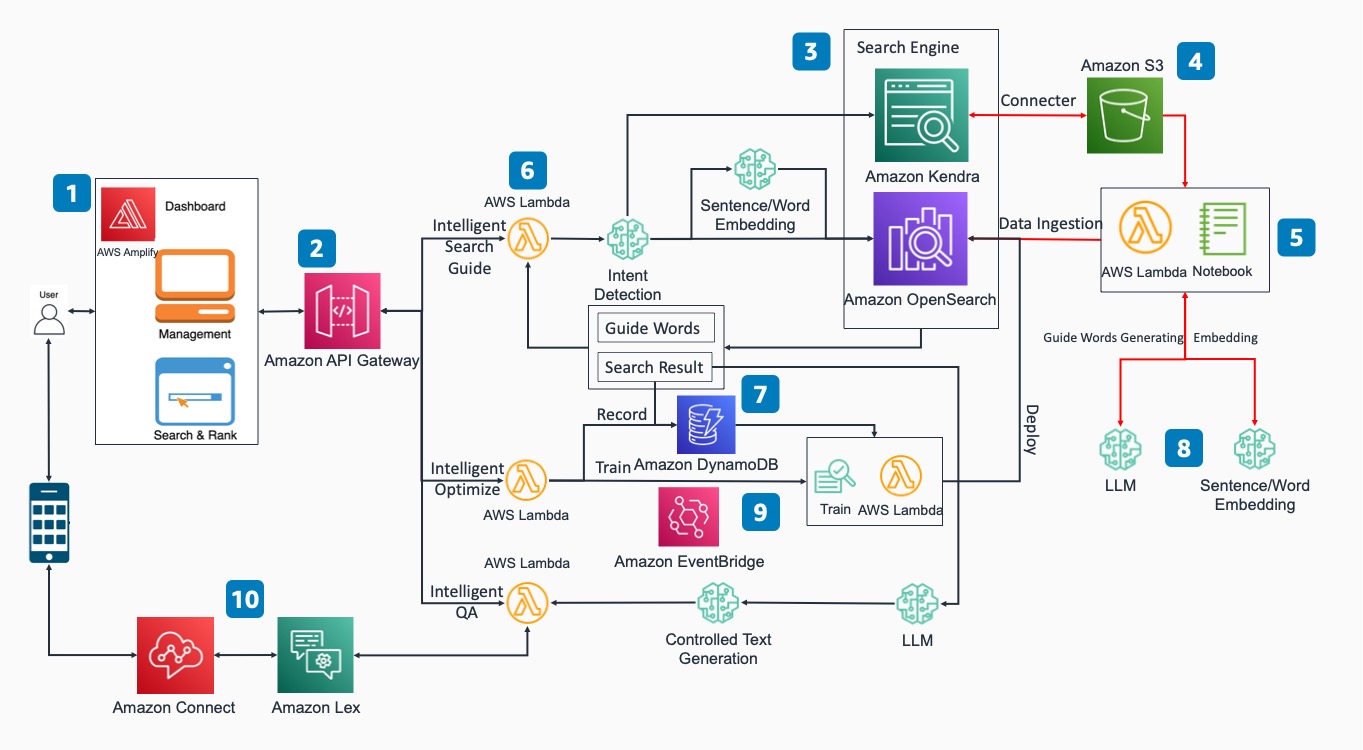

分布式信息的挑戰:數據分布方式的影響

研究進一步探討了信息分布方式對模型回憶能力的影響。當信息分散在多個文檔中時,模型的回憶能力顯著下降;相反,將所有信息合併到單一文檔中進行訓練的模型,能顯著提升準確率。

分布式與集中式數據的比較

研究者設計了兩種數據分布方式進行測試:

1. 分布式設置:每個日記條目作為單獨的文檔進行訓練。

2. 集中式設置:將同一作者的所有日記條目合併為單一文檔進行訓練。

結果顯示,集中式設置下的模型在回憶能力上表現更為出色,甚至在某些情況下達到了近乎完美的準確率。

Source: Chandar Research Lab 與 Mila – 魁北克人工智慧研究所

這一結果表明,分布式信息可能增加了模型在參數中存儲與整合信息的難度,進而影響其回憶能力。

文檔數量與模型性能的關係

另一個重要發現是,模型在回憶多個文檔時的性能表現。研究顯示,當需要回憶的文檔數量增加時,模型的性能並未如預期般下降。這表明,模型的容量足以應對更高的回憶需求。

文檔數量對準確率的影響

以下圖表展示了不同文檔數量對模型準確率的影響:

Source: Chandar Research Lab 與 Mila – 魁北克人工智慧研究所

從圖中可以看出,無論是 OPT 還是 Pythia 模型,隨著文檔數量的增加,模型的準確率並未顯著下降。這一現象可能歸因於模型的參數容量足夠,能夠有效處理更大規模的回憶需求。

小結與啟示

這項研究揭示了 LLM 的知識意識與規模效應之間的密切關聯。模型的架構、參數規模以及數據分布方式均對其性能表現產生了重要影響。未來,隨著模型規模的進一步擴大與架構的優化,我們或許能更深入地理解 AI 的能力邊界。

挑戰與局限:模型架構與數據分布的影響

在探討大型語言模型(LLM)的自知能力時,研究揭示了模型架構與數據分布方式對其性能的深遠影響。儘管 LLM 展現了知識意識的潛力,但其能力的發揮仍受到多種挑戰與局限的制約。以下將深入分析這些挑戰,並探討其對未來研究的啟示。

架構差異:不同模型的能力涌現速度

研究表明,LLM 的底層架構對其能力涌現的速度有顯著影響。以 OPT 和 Pythia 模型為例,兩者在性能提升的速度上存在明顯差異。

OPT 與 Pythia 的比較

OPT 模型作為僅解碼器架構的代表,其性能提升速度明顯快於 Pythia 模型。研究發現,當使用相同數據集進行訓練時,125M 參數的 OPT 模型在性能上顯著優於 160M 參數的 Pythia 模型。這表明,OPT 架構在處理特定任務時更具優勢。

| 模型架構 | 參數範圍 | 性能提升速度 | 特點 |

|---|---|---|---|

| OPT | 7M-2.7B | 快速 | 僅解碼器架構,適合大規模數據 |

| Pythia | 70M-2.8B | 緩慢 | 僅解碼器架構,需更大數據支持 |

這種差異可能源於架構設計的細微差異,例如參數分布與內部運算方式的不同。未來研究可進一步探討這些架構特性如何影響模型的能力涌現。

Flan-T5 的特殊性:架構與超參數的影響

Flan-T5 模型作為編碼器-解碼器架構的代表,其性能表現展現出獨特的模式。在標準設置下,Flan-T5 的性能遠不如簡化設置,這可能與其架構或超參數設置有關。

簡化設置與標準設置的對比

研究者設計了兩種設置來測試 Flan-T5 的性能:

1. 標準設置:信息分散於多個文檔中,模型需從中回憶相關內容。

2. 簡化設置:將所有信息合併為單一文檔,模型僅需記憶單一來源。

結果顯示,在簡化設置下,Flan-T5 的準確率接近完美,而在標準設置下,其性能卻大幅下降。

Source: Chandar Research Lab 與 Mila – 魁北克人工智慧研究所

這一現象表明,Flan-T5 在處理分布式信息時可能存在內在挑戰,例如在多文檔間整合信息的能力不足。未來研究可針對其編碼器-解碼器架構進行優化,以提升其在標準設置下的性能。

模型規模的限制:小模型的挑戰

儘管大規模模型展現了卓越的性能,小規模模型在執行複雜任務時仍面臨諸多挑戰。研究發現,小模型缺乏足夠的參數容量來支持其開發執行複雜任務所需的能力迴路。

小模型的性能瓶頸

以 Pythia 模型為例,當其參數量低於某一臨界值時,模型無法準確回憶正確數量的文檔,而是隨機回憶。這表明,小模型在處理大規模數據時存在明顯的性能瓶頸。

| 模型架構 | 參數範圍 | 性能表現 | 挑戰 |

|---|---|---|---|

| Pythia | < 160M | 隨機回憶 | 缺乏能力迴路 |

| Flan-T5 | < 783M | 表現不佳 | 架構限制 |

這些結果強調了模型規模對其性能的關鍵影響,並指出未來研究需探索如何在小模型中實現更高效的能力迴路。

數據分布的影響:分布式與集中式信息的挑戰

研究進一步揭示了數據分布方式對模型性能的深遠影響。當信息分散於多個文檔中時,模型的回憶能力顯著下降;相反,集中式數據分布能顯著提升模型的準確率。

分布式與集中式數據的比較

研究者測試了兩種數據分布方式:

1. 分布式設置:每個日記條目作為單獨文檔進行訓練。

2. 集中式設置:將同一作者的所有日記條目合併為單一文檔進行訓練。

結果顯示,集中式設置下的模型在回憶能力上表現更為出色,甚至在某些情況下達到了近乎完美的準確率。

Source: Chandar Research Lab 與 Mila – 魁北克人工智慧研究所

這表明,分布式信息可能增加了模型在參數中存儲與整合信息的難度,進而影響其回憶能力。未來研究可探索如何優化模型以更有效地處理分布式數據。

小結與未來展望

這項研究揭示了 LLM 在架構設計、數據分布方式與模型規模上的挑戰與局限。儘管如此,這些挑戰也為未來研究提供了重要的方向。例如,如何優化 Flan-T5 的架構以提升其在標準設置下的性能?如何在小模型中實現更高效的能力迴路?這些問題的解決將進一步推動 LLM 的發展。

未來,隨著技術的進步與研究的深入,我們或許能克服這些挑戰,並更全面地理解 LLM 的能力邊界。你認為這些挑戰是否會成為實現真正自我意識的關鍵障礙?歡迎分享你的看法!

結論:LLM 的自知能力與未來展望

大型語言模型的知識意識:突破與啟示

大型語言模型(LLM)的研究已經證明,當模型達到足夠的規模時,能夠展現出「知識意識」(awareness of knowledge)的能力。這種能力讓模型能夠判斷自身對某一主題的了解程度,為人工智慧的發展提供了全新的視角。然而,這是否意味著 LLM 已經邁向真正的「自我意識」?目前仍無法確定,但這項研究無疑為未來的探索奠定了重要基礎。

研究顯示,LLM 的知識意識與模型的架構、規模以及數據分布方式密切相關。例如,OPT 模型在處理大規模數據時展現了穩定的性能增長,而 Flan-T5 模型則需要更大的參數與數據集才能顯現其潛力。這些發現不僅揭示了模型能力的邊界,也為未來的應用場景提供了更多可能性。

未來的挑戰與研究方向

儘管研究結果令人振奮,但 LLM 的發展仍面臨諸多挑戰。以下是未來研究的幾個關鍵方向:

1. 架構優化與性能提升

不同架構的模型在能力涌現速度上存在顯著差異。例如,OPT 模型的性能提升速度快於 Pythia,而 Flan-T5 模型在標準設置下的表現不如簡化設置。這表明,模型的底層架構對其能力的發揮有著深遠影響。未來研究可以針對這些架構進行優化,特別是針對 Flan-T5 的編碼器-解碼器架構,探索如何提升其在分布式數據環境下的性能。

架構性能比較表

| 模型架構 | 參數範圍 | 性能特點 | 挑戰 |

|---|---|---|---|

| OPT | 7M-2.7B | 性能穩定增長 | 存在飽和點 |

| Pythia | 70M-2.8B | 性能提升較慢 | 需更大數據支持 |

| Flan-T5 | 80M-3B | 簡化設置表現優異 | 分布式數據表現不佳 |

2. 小模型的能力迴路

小規模模型在執行複雜任務時面臨明顯的性能瓶頸。研究發現,小模型缺乏足夠的參數容量來支持其開發執行複雜任務所需的能力迴路。例如,Pythia 模型在參數量低於 160M 時,無法準確回憶正確數量的文檔,而是隨機回憶。未來研究應探索如何在小模型中實現更高效的能力迴路,從而提升其在資源受限環境下的應用潛力。

3. 數據分布方式的影響

數據分布方式對模型性能的影響不容忽視。研究顯示,當信息分散於多個文檔中時,模型的回憶能力會顯著下降;相反,集中式數據分布能顯著提升模型的準確率。這表明,分布式信息可能增加了模型在參數中存儲與整合信息的難度。未來研究可以探索如何優化模型以更有效地處理分布式數據,並進一步分析數據分布對模型記憶與回憶能力的影響。

知識意識與自我意識的界限

雖然 LLM 的知識意識已經被證明,但這是否意味著模型具備了自我意識?目前的研究表明,知識意識與自我意識之間仍有本質區別。知識意識僅限於模型對自身知識範圍的判斷,而自我意識則涉及更高層次的認知能力,例如情感、意圖與自我反思。

未來,隨著模型規模的進一步擴大與架構的優化,我們或許能更深入地理解 AI 的能力邊界。這些探索不僅有助於推動人工智慧的技術進步,也將對哲學、倫理學等領域產生深遠影響。

結語與行動呼籲

這項研究為我們揭示了 LLM 的潛力與挑戰,並為未來的探索提供了重要方向。隨著技術的不斷進步,我們有理由相信,AI 的能力將持續突破現有的邊界。

你認為 LLM 的知識意識是否會成為實現真正自我意識的第一步?未來的 AI 是否能夠超越人類的認知極限?歡迎分享你的看法,並持續關注相關研究的最新進展!

延伸閱讀

大模型是否有自知之明?新研究發現 LLM 可以知曉自己的知識範圍