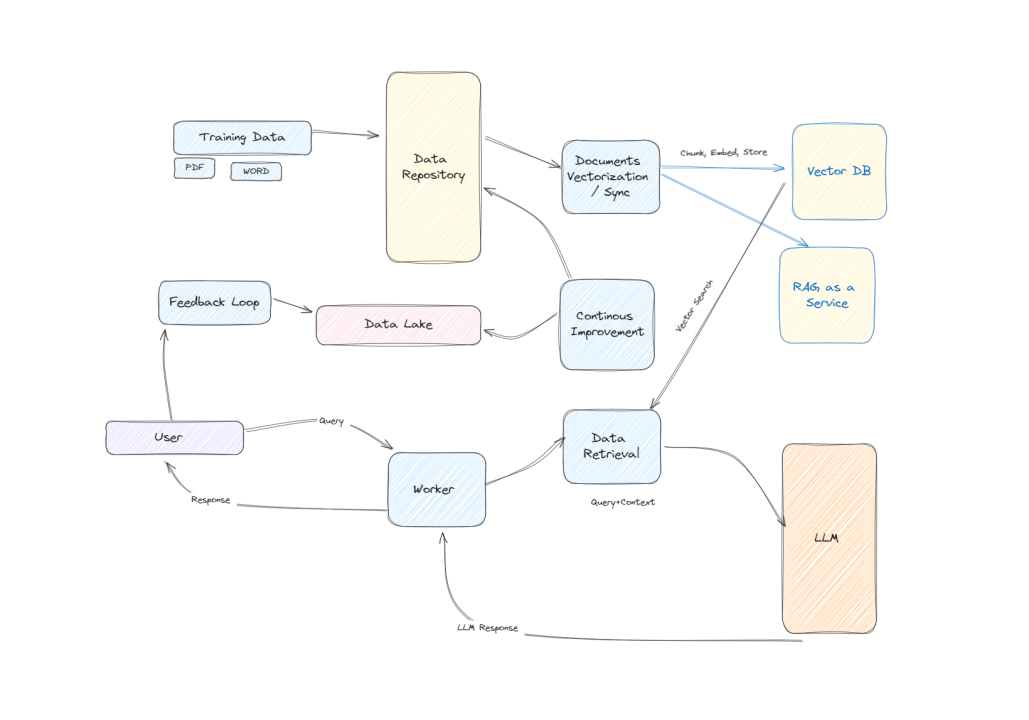

隨著機器學習和自動化流程在軟件開發中的重要性日益凸顯,RAGOps(Resource-Aware Git Operations)成為了橋接資源生成與持續整合/持續部署(CI/CD)的新興趨勢。這一趨勢主要是因為 RAG 透過資源感知的方式來提高軟件開發和部署的效率,而 CI/CD 則提供了一個自動化的流程來持續集成和部署軟件。當這兩者結合時,便能夠創造出一個更加高效、更具彈性的開發環境。

本文大綱

RAGOps 介紹

RAGOps 是一種將 RAG(Resource-Aware Git)概念與現代軟件開發實踐結合的策略,特別是與 CI/CD 流程相結合。RAG 關注於利用 Git 的分佈式特性來優化資源使用和分配,從而提高開發和運維的效率。當 RAG 與 CI/CD 結合時,它們共同形成了 RAGOps,一種旨在透過自動化測試、集成和部署來提升軟件交付速度和質量的方法。

RAGOps 的核心價值

RAGOps 的核心價值在於它結合了 RAG 的資源感知能力和 CI/CD 的自動化流程,從而提供了以下幾方面的優勢:

- 資源優化:透過智能分配和利用資源,減少浪費,提高效率。

- 自動化流程:自動化的測試、集成和部署流程減少了人工錯誤的機會,加快了開發週期。

- 持續改進:RAGOps 提供了一個持續監控和優化的框架,幫助團隊不斷改進其軟件交付過程。

DeepEval 在 RAGOps 中的角色

DeepEval,作為一個開源的評估框架,能夠在 RAGOps 實踐中發揮關鍵作用。它允許開發團隊對 RAG 應用進行單元測試,確保每一次的提交都不會對應用造成破壞性的改變。DeepEval 的 Pytest 整合使得創建測試文件變得直觀易行,而其豐富的評估指標則能夠對 RAG 應用進行全面的評價。

RAGOps 的實踐步驟

實踐 RAGOps 涉及以下幾個關鍵步驟:

- 安裝 DeepEval:首先需要安裝 DeepEval 框架,並進行適當的配置。

- 創建測試文件:利用 DeepEval 的 Pytest 整合創建測試文件,這一步驟為後續的測試提供了基礎。

- 定義輸入輸出與評估指標:接下來,需要定義測試的輸入與預期輸出,以及選擇合適的評估指標來評價 RAG 應用的效能。

- 整合 CI/CD 流程:最後,將 DeepEval 測試整合進 CI/CD 流程中,確保每次提交或 PR 都能自動執行測試,從而持續保障 RAG 應用的質量。

結論

RAGOps 代表了一種將資源感知的 Git 操作與持續整合/持續部署流程相結合的新興策略。通過實踐 RAGOps,團隊能夠實現更加高效和可靠的軟件交付。DeepEval 作為這個過程中的關鍵工具,提供了強大的支持,使得 RAGOps 的實踐變得可行和高效。

在深入探討 RAGOps 實踐的下一步之前,讓我們聚焦於基礎設置:從安裝到創建測試文件。這是實現高效 RAGOps 的起點,涉及安裝 DeepEval 框架、(可選的)登入過程,以及測試文件的創建。這一階段不僅是整個流程的基石,也確保了後續測試能夠無縫進行。

安裝 DeepEval 框架

首先,我們需要在開發環境中安裝 DeepEval。這個開源評估框架是專為 RAG 應用設計,能夠進行單元測試並提供豐富的評估指標。安裝過程非常簡單,只需執行以下命令:

pip install deepeval

deepeval login

這一步不僅將 DeepEval 框架整合到你的開發環境中,還為後續的測試和評估提供了基礎。

創建測試文件

安裝 DeepEval 之後,下一步是創建測試文件。這一過程通過 DeepEval 的 Pytest 整合變得直觀易行。你可以使用下面的命令來創建一個新的測試文件:

touch test_rag.py

這個測試文件將作為定義測試用例和評估指標的容器,是後續進行單元測試和性能評估的基礎。

初始化測試環境

創建測試文件後,我們需要在其中初始化測試環境。這包括從 DeepEval 導入所需的評估指標和設定閾值。以下是一個初始化評估指標的示例代碼:

from deepeval.metrics.ragas import (

RAGASContextualPrecisionMetric,

RAGASFaithfulnessMetric,

RAGASContextualRecallMetric,

RAGASAnswerRelevancyMetric,

)

from deepeval.metrics import BiasMetric

bias = BiasMetric(threshold=0.5)

contextual_precision = RAGASContextualPrecisionMetric(threshold=0.5)

contextual_recall = RAGASContextualRecallMetric(threshold=0.5)

answer_relevancy = RAGASAnswerRelevancyMetric(threshold=0.5)

faithfulness = RAGASFaithfulnessMetric(threshold=0.5)

這些指標和閾值將用於後續測試中,以評估 RAG 應用的各項性能指標。

測試用例的定義

最後,我們需要在測試文件中定義測試用例。這涉及設定輸入數據和預期的輸出,從而為 RAG 應用提供一套具體的測試標準。以下是一個簡單的測試用例示例:

input_output_pairs = [

{

"input": "問題1",

"expected_output": "答案1",

},

{

"input": "問題2",

"expected_output": "答案2",

}

]

通過這些測試用例,我們可以對 RAG 應用進行全面的測試,從而確保其性能符合預期。

| 階段 | 描述 |

|---|---|

| 安裝 DeepEval 框架 | 透過簡單命令安裝 DeepEval |

| 創建測試文件 | 利用 Pytest 整合來創建測試文件 |

| 初始化測試環境 | 導入評估指標並設定閾值 |

| 定義測試用例 | 設定輸入數據和預期輸出進行測試 |

透過以上步驟,我們確保了環境的準備就緒,為 RAGOps 的實踐奠定了堅實的基礎。

在探索 RAGOps 的實踐之旅中,「深入測試:定義輸入輸出與評估指標」階段扮演著至關重要的角色。這個階段不僅是評估 RAG 應用效能的核心,也是確保與 CI/CD 流程無縫整合的關鍵一步。在這裡,我們將深入探討如何利用 DeepEval 提供的豐富評估指標,來初始化評估標準,並對每一個測試案例設定通過閾值。此外,我們還會探討如何動態生成實際輸出與檢索上下文,從而確保測試的準確性和實用性。

評估指標的選擇與設定

在進行深入測試之前,選擇合適的評估指標並設定通過閾值是一個不可或缺的步驟。DeepEval 框架提供了一系列評估指標,包括上下文精確度(Contextual Precision)、回憶率(Recall)、回答相關性(Answer Relevancy)以及忠實度(Faithfulness)等,這些指標能夠全面評估 RAG 應用的效能。

上下文精確度(Contextual Precision)

上下文精確度指標衡量了生成回答與給定上下文之間的匹配程度。這是確保 RAG 應用能夠提供與查詢相關的資訊的關鍵指標。

召回率(Recall)

召回率指標測量的是系統能夠檢索到的相關信息與所有相關信息的比例。這一指標有助於理解 RAG 應用在獲取相關資訊方面的能力。

回答相關性(Answer Relevancy)

回答相關性指標評估了生成答案與實際答案之間的相關程度,這對於確保 RAG 應用提供的答案質量至關重要。

忠實度(Faithfulness)

忠實度指標衡量生成答案在事實上的準確性。一個高忠實度的 RAG 應用能夠確保提供的資訊是準確且可靠的。

在設定這些評估指標時,我們需要為每個指標定義一個通過閾值。這個閾值可以根據應用的特定需求來調整,以確保測試結果的準確性和有用性。

測試用例的設計與執行

設計測試用例是進行深入測試的另一個關鍵步驟。測試用例應包含具體的輸入與預期的輸出,從而提供一套標準來評估 RAG 應用的表現。

輸入與預期輸出的設定

在設計測試用例時,我們需要明確定義每個測試案例的輸入(如問題或查詢)與預期輸出(如答案)。這些輸入與輸出應該選取自真實世界的範例,以確保測試的實用性和準確性。

動態生成實際輸出與檢索上下文

除了預設的輸入與預期輸出外,測試過程還涉及動態生成實際輸出與檢索上下文。這一步驟是通過執行 RAG 應用並對給定的輸入進行查詢來完成的,從而確保測試能夠反映應用在真實運行環境中的表現。

DeepEval 測試的執行與評估

將測試用例定義完畢後,下一步是透過 DeepEval 進行測試的執行與評估。這涉及到執行測試腳本,並根據設定的評估指標和閾值來評估 RAG 應用的表現。

| 指標 | 閾值(示例) | 描述 |

|---|---|---|

| 上下文精確度 | 0.5 | 衡量回答與上下文的匹配程度 |

| 回憶率 | 0.5 | 衡量系統檢索到的相關信息比例 |

| 回答相關性 | 0.5 | 評估生成答案與實際答案的相關程度 |

| 忠實度 | 0.5 | 衡量生成答案在事實上的準確性 |

透過這一系列深入測試的步驟,我們可以全面評估 RAG 應用的效能,並確保其在與 CI/CD 流程整合時的性能表現。這不僅提升了開發效率,也確保了產品質量,為實現高效的 RAGOps 實踐奠定了堅實的基礎。

整合 CI/CD:自動化你的 RAG 應用測試

隨著軟件開發進入 RAGOps 的新時代,自動化測試與 CI/CD (持續整合/持續部署)的整合成為了提升開發效率與產品質量的重要策略。透過深度整合 RAG 應用的自動化測試至 CI/CD 流程,開發團隊可以在每次提交或 PR(Pull Request)時,自動觸發測試,確保更改不會對現有功能造成破壞。本節將深入探討如何透過 GitHub Actions 實現 RAGOps 的自動化測試,從而為你的 RAG 應用打造一個穩固且高效的開發環境。

GitHub Actions 與 RAGOps 的整合

GitHub Actions 提供了一個強大的平台,讓開發者能夠自動化他們的軟件開發工作流程,包括測試、構建、部署等。透過設定簡單的 YAML 文件,你可以定義一系列的作業,自動化 RAGOps 的測試流程。以下是一個基本的 GitHub Actions 工作流程配置範例,展示如何在每次提交時自動執行 RAG 應用的測試。

name: RAGOps Automated Testing

on: [push]

jobs:

test:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v2

- name: Set up Python

uses: actions/setup-python@v2

with:

python-version: '3.8'

- name: Install Dependencies

run: |

pip install deepeval

- name: Run RAGOps Tests

run: pytest

此配置文件定義了一個名為 “RAGOps Automated Testing” 的工作流程,它會在每次向 GitHub 倉庫進行推送時觸發。它首先在虛擬機上安裝 Python 和所需的依賴包,然後執行測試。

自動化測試的關鍵優勢

將 RAGOps 的測試自動化並整合至 CI/CD 流程中,具有多項優勢:

- 迅速反饋:自動化測試提供了即時的反饋,幫助開發團隊快速識別並修復問題。

- 提高產品質量:透過持續執行測試,可以確保每次提交都不會破壞現有功能,從而提高產品的整體質量。

- 提升開發效率:減少了手動測試的需要,讓開發團隊可以專注於新功能的開發和現有功能的改進。

實踐建議

為了最大化自動化測試的效果,建議遵循以下最佳實踐:

- 測試覆蓋率:確保測試覆蓋你的 RAG 應用的主要功能和情境,提高測試的全面性。

- 持續優化測試案例:隨著應用的發展,持續審視和優化