【論文筆記】DCFEE:基於自動標記訓練數據的文檔級中文金融事件抽取系統

抽取金融事件能幫助用戶獲得競爭對手的戰略,預測股票市場做出正確的投資決策。舉例來說,股權凍結事件將對公司產生不利影響,股票持有者應迅速判斷避險

[PyTorch] 使用 torch.distributed 在單機多 GPU 上進行分散式訓練

Finetune 語言模型所需要的 GPU memory 比較多,往往會需要我們能夠利用到多顆 GPU 的資源。今天這篇文章會說明 DataParallel 和 DistributedDataParallel + DistributedSampler 兩種進行模型分散式訓練的方式。

經典 NLP 任務標籤生成:串接非官方 ChatGPT API

這篇文章紀錄我串接非官方 ChatGPT API 「試圖」取得 NLP 資訊抽取任務標籤的過程。結論是…

NLP 界的核武:ChatGPT 實測心得和未來應用分析

大家最想知道,核武級的 ChatGPT 出現後該如何應對?

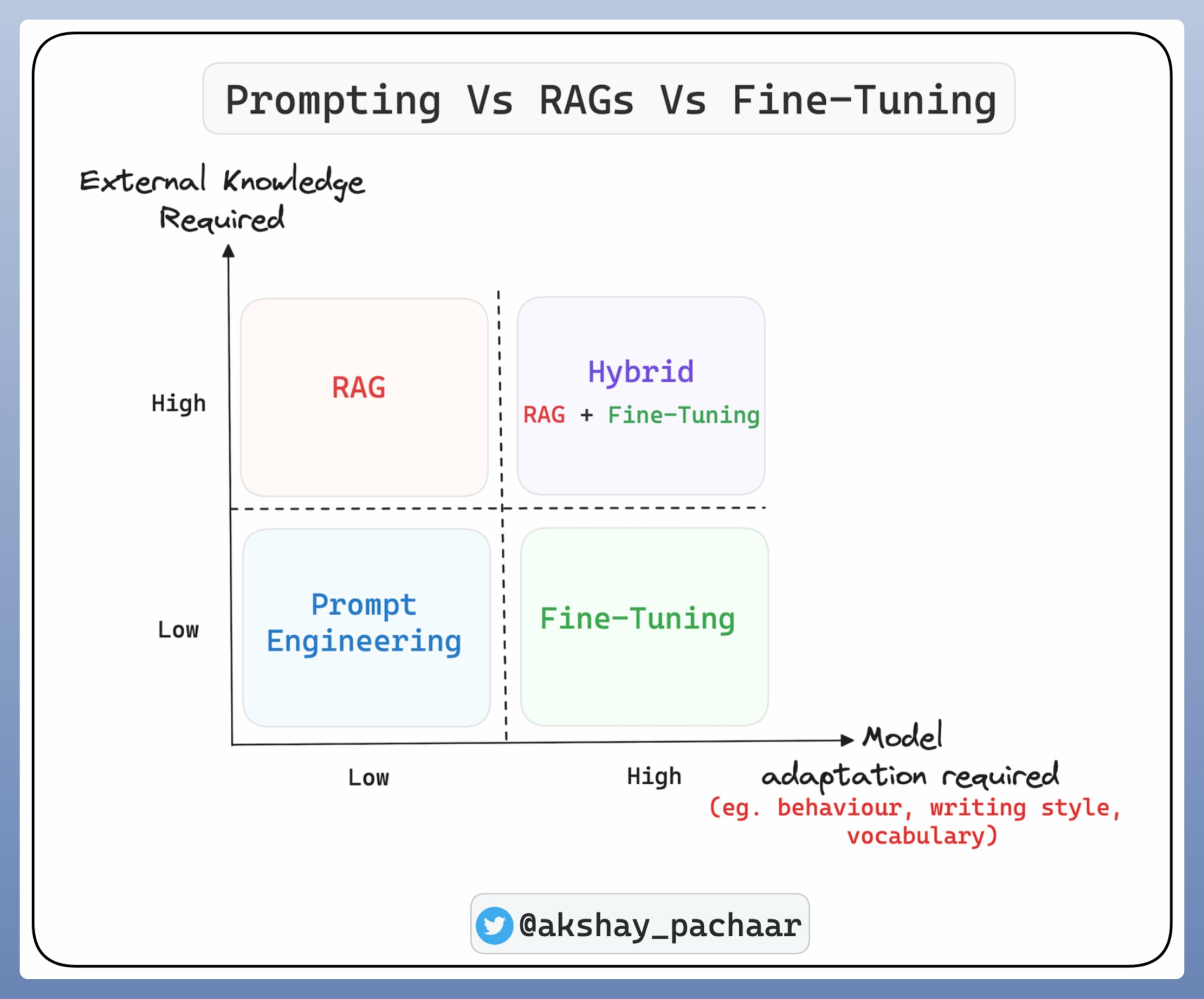

未來的運作方式可能會變成像是 人類先有一個 idea ,先請 AI 做初步的資料蒐集、整理,再由人類做判斷、再使用 類似 Prompt Engineering 的方式進行微調,用這樣的方式和 AI 協作。

【自然語言處理】基於語義角色標註的事件三元組抽取實作

本文介紹自然語言處理中的經典任務之一:語義角色標註,並分享開源專案「事件三元組抽取」如何利用語義角色標注的結果,以及復現心得、改良想法

![[PyTorch] 使用 torch.distributed 在單機多 GPU 上進行分散式訓練](https://idataagent.com/wp-content/uploads/2021/02/pexels-photo-270360.jpeg)