隨著人工智慧技術的快速發展,小型語言模型(small language model, SLM)因其計算效率高和適應性強而受到廣泛關注。這些模型在資源受限的設備上展現出巨大的潛力,使得在不同的應用場景下,都能夠實現高效的語言處理任務。然而,隨著應用的深入,小型語言模型面臨著過拟合、泛化能力不足等關鍵技術問題,需要通過創新的方法來解決。

本文大綱

小型語言模型的崛起背景

在過去幾年中,我們目睹了小型語言模型的迅速崛起。其背後的驅動力之一是對於高效計算的需求。隨著技術的進步,人們對於在各種設備上進行自然語言處理(NLP)任務的需求日益增加。從智慧手機到物聯網(IoT)設備,從邊緣計算到雲端服務,小型語言模型因其低延遲和高效率而成為首選。

小型語言模型的發展,受到了處理速度、資源消耗以及客製化需求的推動。這些模型因其相對較小的規模,在資源受限的應用場景中顯得格外重要。此外,小型語言模型能夠提供更好的適應性,使其在特定的應用場景中能夠達到更優的效果。但是,過拟合問題仍是限制小型語言模型應用範圍的一大障礙。這一問題導致模型在訓練數據上表現出色,但對於未見過的數據則難以泛化。這主要源於小型模型的學習容量有限,難以捕捉到語言數據中的複雜模式和多樣性。

面對這些挑戰,學術界和工業界已提出多種解決策略和技術。包括數據擴增、正則化技術以及更細粒度的訓練數據篩選等,均為提高小型語言模型的泛化能力而努力。特別是,數據擴增通過生成新的訓練樣本來增加數據集的多樣性,而正則化技術如 Dropout 或權重衰減則可以有效降低模型的複雜度,減少對訓練數據的過度擬合。此外,針對小型語言模型的細粒度訓練數據篩選方法,透過質量評估保留對模型學習最有用的樣本,也展現了對抗過拟合問題的潛力。

儘管過拟合問題為小型語言模型的發展帶來了挑戰,但隨著技術的不斷進步和優化,這些模型在多個領域的應用前景仍然廣闊。未來,小型語言模型有望在保持其處理速度和資源消耗優勢的基礎上,通過實施有效的解決方案克服過拟合問題,實現在更廣泛領域的應用。為了達到這一目標,持續的創新和研究將是關鍵。這包括開發更先進的數據處理和模型訓練技術,以及探索新的模型架構和優化策略。

隨著技術的發展,我們有理由相信小型語言模型將在未來扮演更加重要的角色,為語言處理領域帶來革命性的變革。對於感興趣的研究者和從業者來說,現在是深入了解並探索小型語言模型潛力的最佳時機。

小型語言模型面臨的關鍵挑戰

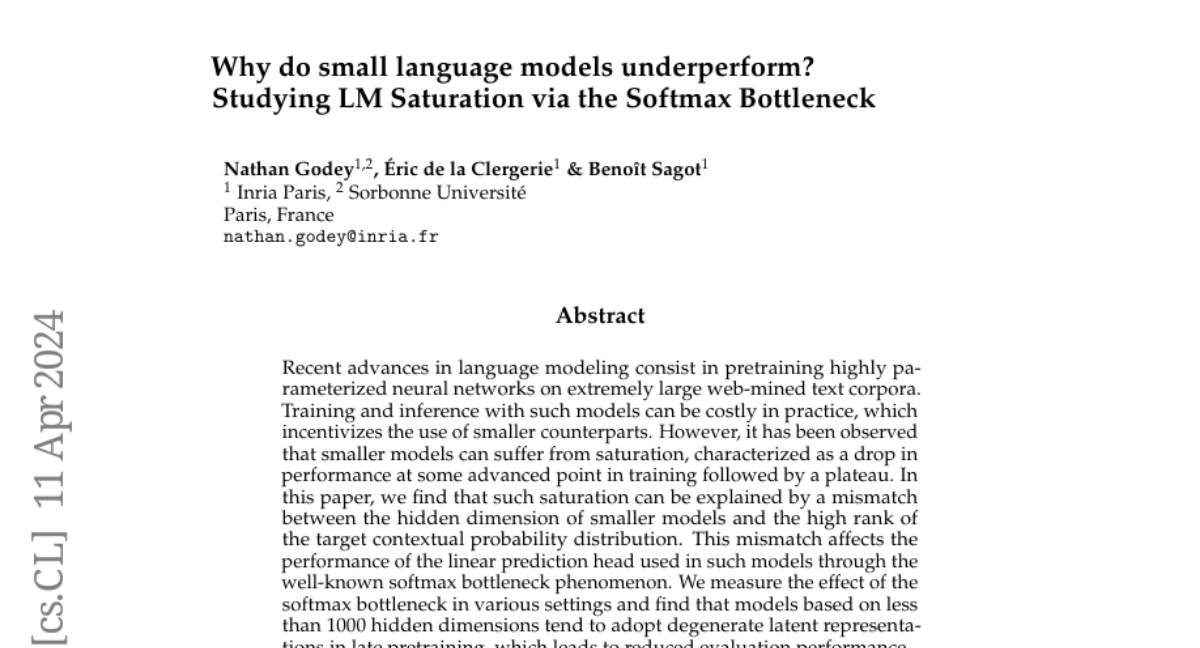

隨著小型語言模型 (Small Language Model, SLM) 在人工智慧領域日趨重要,它們在處理複雜語言任務時所面臨的挑戰也逐漸浮現。首先,模型的隱藏維度與目標上下文概率分布的不匹配導致所謂的 softmax 瓶頸現象,這一現象直接影響了模型中線性預測頭的性能。此外,模型在訓練過程中的特定階段達到饱和點,導致性能下降,這一現象通常被稱為表征退化問題。

Softmax 瓶頸與隱藏維度的不匹配

隱藏維度與目標上下文概率分布的不匹配,是導致小語言模型面臨性能饱和的主要原因之一。在訓練過程中,當模型試圖學習的目標概率分布遠遠超過模型的隱藏維度所能表達的範圍時,就會出現所謂的 softmax 瓶頸。這種現象導致模型難以準確預測目標上下文,進而影響整體性能。

線性預測頭的影響

線性預測頭的性能直接受到 softmax 瓶頸的影響。當模型的隱藏維度無法有效捕捉目標概率分布的復雜性時,線性預測頭在進行下一個詞預測時的準確率大幅下降。這種性能下降在模型需要處理高度多樣化的語言結構和上下文時尤為明顯。

表征退化問題

表征退化問題是另一個導致小語言模型性能饱和的重要因素。隨著模型訓練的進行,模型的學習能力可能達到一個臨界點,此時模型的內部表征開始退化,導致性能逐漸下降。這一問題通常在模型的後期訓練階段出現,當模型開始過度擬合訓練數據或無法進一步提取有用特徵時。

解決策略

針對 Softmax 瓶頸和表征退化問題,學者提出了多種解決策略。對於 Softmax 瓶頸,通過調整模型架構中的隱藏維度大小,以及優化語言模型頭部的結構,可以在一定程度上減少或消除這一現象。對於表征退化問題,增加訓練數據的多樣性和量級,可以提升模型的泛化能力,從而延緩或避免性能饱和。這些策略為小語言模型的發展提供了新的思路和方法。

過拟合問題的挑戰

過拟合是小型語言模型常見的一大問題,這導致模型在訓練數據上表現出色,但對於未見過的數據則難以泛化。這一問題的根本原因在於模型的學習容量有限,難以捕捉到語言數據中的複雜模式和多樣性。此外,模型可能過度依賴於訓練數據集中的特定樣本,進一步加劇了過拟合問題。

泛化能力不足的挑戰

泛化能力不足是小型語言模型面臨的另一大挑戰。由於模型的規模較小,使其難以有效學習到足夠廣泛的語言規則和模式,從而影響模型在新的或未見過的數據上的表現。這一挑戰對於希望在多樣化應用場景中部署小型語言模型的開發者而言尤為關鍵。

技術創新解決之道

為了克服上述挑戰,學術界和工業界提出了多種解決策略和技術。其中,Phi 和 Mixtral 技術在近年來顯示了通過創新算法和模型結構來解決小型語言模型挑戰的巨大潛力。

隱藏維度的調整與優化

最近的研究指出,調整小語言模型的隱藏維度大小與優化語言模型頭部的結構,能夠在一定程度上減少或消除所謂的 softmax 瓶頸現象。這種現象是由於模型的隱藏維度與目標上下文概率分布的高秩之間的不匹配所導致的。通過增加模型的隱藏層維度,可以擴大其學習到的特徵空間,從而提高模型對複雜語言結構的捕捉能力。

數據多樣性的提升

另一方面,增加訓練數據的多樣性和量級也被證明是一種有效的策略。透過引入更多樣化的數據,模型能夠學習到更廣泛的語言模式,從而提升其泛化能力。這不僅有助於延緩性能饱和的發生,而且還能夠在面對未見過的語言結構時,提供更加準確的預測。

Phi 技術

Phi 技術透過創新的模型訓練和結構優化方法,提高了模型對數據的利用效率,從而在不增加模型大小的前提下,提升小型語言模型的學習和泛化能力。這種方法通過提高模型內部的資訊流動效率,使其能夠更好地捕捉和學習語言數據中的複雜模式。

Mixtral 技術

Mixtral 技術則採用了一種新穎的混合專家系統(Mixture of Experts, MoE),通過將輸入動態分配給不同的「專家」處理,提高了模型的處理效率和輸出品質。這種方法使小型語言模型在處理特定任務時能夠展現出與大型模型相媲美的性能,同時保持了小型模型的高效與靈活性。

| 技術 | 描述 | 優勢 |

|---|---|---|

| Phi | 透過模型訓練和結構優化提升學習效率 | 提高泛化能力,不增加模型大小 |

| Mixtral | 採用混合專家系統提高處理效率 | 與大型模型性能相媲美,保持高效性 |

通過這些技術創新,小型語言模型在追求計算效率和模型小型化的同時,也能夠有效提升其性能和適應性,為語言模型的應用開拓了新的可能性。

在面對過拟合和泛化能力不足等挑戰時,Phi 和 Mixtral 技術的應用提供了一條有效的解決途徑。隨著技術的持續創新和發展,小型語言模型有望在未來的人工智慧應用中發揮更加重要的作用,推動語言處理技術的進步和創新。

在探索小型語言模型(Small Language Model, SLM)面臨的關鍵挑戰時,過拟合和泛化能力不足問題尤為突出。這些問題不僅限制了模型的應用範圍,更阻礙了模型在複雜語言任務中的表現。為了克服這些挑戰,學術界和工業界提出了多種策略和技術,其中 Phi 和 Mixtral 技術顯示了巨大的潛力。本節將深入探討這些解決方案的應用及其對小型語言模型發展的影響。

數據擴增技術:提高多樣性

數據擴增技術是對抗過拟合問題的有效手段之一。通過生成新的訓練樣本來增加數據集的多樣性,這種方法有助於模型學習到更通用的語言規則,從而提升其泛化能力。例如,透過同義詞替換、句子重組等方法,可以創建語義相同但表達不同的新數據樣本,從而增加模型對未見過數據的適應能力。

正則化技術:降低模型復雜度

正則化技術,如 Dropout 和權重衰減,是另一種常見的過拟合解決策略。這些技術通過限制模型的參數值或隨機忽略一部分神經元,來降低模型的復雜度。這樣可以有效防止模型過度依賴訓練數據集中的特定樣本,提高它對新數據的泛化能力。

細粒度訓練數據篩選:提高訓練效率

隨著人工智能技術的進步,更細粒度的訓練數據篩選方法也被開發出來,這對小型語言模型特別有用。通過對訓練數據進行質量評估,只保留那些對模型學習最有用的樣本,可以有效提高訓練效率並減少過拟合風險。

綜上所述,面對小型語言模型所遭遇的過拟合和泛化能力不足的挑戰,通過數據擴增、正則化技術、細粒度訓練數據篩選,以及 Phi 和 Mixtral 等創新技術的應用,提供了有效的解決途徑。這些策略和技術的結合應用,不僅提升了小型語言模型的性能,也為其在更廣泛的應用場景中的部署提供了強有力的支持,為未來語言處理技術的創新與進步開辟了新的道路。

儘管目前小型語言模型(small language model, small LLM)面臨著多項挑戰,但隨著技術的進步和創新策略的應用,這些挑戰將逐步被克服。未來的發展方向可能包括開發更先進的模型結構、探索更有效的數據處理和訓練方法,以及利用人工智慧新技術提高模型的學習和適應能力。對於研究者和技術開發者來說,現在是深入了解小型語言模型潛力並探索其創新應用的最佳時機。

未來發展方向

隨著小型語言模型在多個領域的應用日益增加,未來的發展方向將集中於幾個關鍵領域:

更先進的模型結構

未來,小型語言模型的結構將變得更加先進和高效。技術如 Phi 和 Mixtral 已展示出通過創新算法和模型結構來解決小型語言模型挑戰的潛力。這些技術通過提高模型內部的資訊流動效率以及利用混合專家系統來提升處理效率和輸出品質,為小型語言模型的優化提供了新的方向。

效率和適應性的提升

小型語言模型的未來發展亦將專注於進一步提升計算效率和模型適應性。這將使得小型語言模型不僅能夠在資源有限的設備上運行,同時也能夠快速適應各種不同的應用場景和需求。透過持續的技術創新,小型語言模型將能夠在保持輕量級的同時,提供與大型模型相媲美的性能。

數據處理和訓練方法的創新

隨著數據量的不斷增長,探索更有效的數據處理和訓練方法將成為未來發展的重要方向之一。透過改進數據擴增、正則化技術以及細粒度訓練數據篩選等策略,可以進一步提升小型語言模型的泛化能力並減少過拟合的風險。這將使得小型語言模型能夠更有效地學習和適應各種複雜的語言任務。

人工智慧新技術的應用

隨著人工智慧技術的不斷進步,利用新技術提高小型語言模型的學習和適應能力將成為未來的另一發展方向。這包括探索如何將深度學習、強化學習等先進技術應用於小型語言模型中,以實現更高效的學習過程和更優的性能表現。

總結而言,小型語言模型的未來發展將集中於進一步提升模型的效率、適應性、和泛化能力。隨著技術進步和創新策略的應用,小型語言模型有望在未來的人工智慧應用中發揮更加關鍵的角色,為語言處理技術的進步和創新開辟新的道路。

在當今的人工智慧時代,小型語言模型(small language model, SLM)已成為技術創新和應用發展的關鍵因素之一。隨著計算資源的限制和對高效處理能力的需求不斷增長,小型語言模型以其較低的資源消耗和快速響應能力,在多個領域中展現出巨大的潛力。然而,儘管這類模型在提升計算效率和適應性方面取得了顯著成果,它們在面臨複雜語言處理任務時仍然遭遇著過拟合和泛化能力不足等技術挑戰。為了克服這些問題,學術界和工業界積極尋找創新的解決方案,其中,Phi 和 Mixtral 技術的提出,為解決小型語言模型面臨的挑戰提供了新的思路。

結論與行動呼籲

小型語言模型作為人工智慧領域的一個重要分支,在提高計算效率和模型適應性方面展現出巨大的潛力。面對過拟合和泛化能力問題,通過創新解決方案和技術的應用,這些挑戰將成為推動小型語言模型發展的動力。我們鼓勵業界同仁和研究人員進一步探索小型語言模型的潛力,共同推動這一領域的創新和進步。讓我們一起期待小型語言模型在未來人工智慧應用中扮演更加關鍵的角色。