引言

在當今快速發展的科技時代,人工智慧(AI)技術的進步已經深刻地改變了我們的生活和工作方式。AI 代理評估平台的出現,標誌著一個新的技術時代的來臨。這些平台不僅是技術工具,更是未來技術趨勢的關鍵驅動力。Galileo Technologies Inc. 最近推出的 Agentic Evaluations 平台,專注於評估由大型語言模型(LLM)驅動的 AI 代理的性能,這一創新舉措引起了業界的廣泛關注。

AI 代理具備強大的決策能力,能夠在多步驟中計劃、推理和執行任務,並適應變化的環境和上下文。這些特性使得 AI 代理在提升工作流程效率方面具有巨大潛力。然而,AI 代理的行為具有情境性,這使得開發者難以理解何時以及為何會發生故障。根據 Gartner Inc. 的預測,到 2028 年,33% 的企業軟體應用將包含代理 AI,而 2024 年這一比例不到 1%。這一數據顯示了 AI 代理技術的廣闊前景。

Source: [Galileo unleashes platform for evaluating AI agents] from SiliconANGLE

Galileo 的 Agentic Evaluations 平台提供了一個完整的生命周期框架,用於系統級和逐步評估。該平台為開發者提供了從輸入到完成的整個多步驟代理過程的視圖,並通過追蹤和簡單的可視化幫助開發者快速找出低效和錯誤。這些功能使得開發者能夠更好地理解和優化 AI 代理的行為,從而提高工作流程的效率和準確性。

在這篇文章中,我們將深入探討 AI 代理評估平台的作用及其對未來技術的影響。我們將分析這些平台如何幫助開發者應對 AI 代理的複雜性和挑戰,並探討它們在提高工作流程效率和準確性方面的潛力。通過這些分析,我們希望能夠為讀者提供一個全面的視角,幫助他們更好地理解和應用這一新興技術。

在接下來的部分中,我們將詳細介紹 AI 代理的複雜性與挑戰,並探討 Galileo 的 Agentic Evaluations 平台如何提供解決方案。這些內容將幫助讀者更深入地了解 AI 代理技術的現狀和未來發展方向。

AI 代理的複雜性與挑戰

在人工智慧(AI)技術的發展中,AI 代理的出現為企業帶來了前所未有的機遇與挑戰。這些代理不僅能夠自主決策,還能在多步驟中計劃、推理和執行任務。然而,AI 代理的行為具有高度的情境性,這使得開發者在理解其故障原因時面臨困難。這一部分將深入探討 AI 代理的複雜性及其帶來的挑戰。

本文大綱

AI 代理的情境性行為

AI 代理的行為往往取決於特定的情境,這使得其行為模式難以預測。這種情境性行為意味著代理可能在不同的環境中表現出不同的反應,這對於開發者來說是一個巨大的挑戰。開發者需要理解代理在何種情況下會選擇特定的行動序列,並且這些行動序列可能會因用戶請求的不同而有所變化。這種不可預測性增加了開發和測試的難度。

Source: [Galileo unleashes platform for evaluating AI agents] from SiliconANGLE

根據 Gartner Inc. 的預測,到 2028 年,33% 的企業軟體應用將包含代理 AI,而 2024 年這一比例不到 1%。這一數據顯示了 AI 代理技術的廣闊前景,但同時也反映了其複雜性帶來的挑戰。開發者需要新的方法來應對這些挑戰,以確保代理的行為符合預期。

複雜的工作流程與評估

AI 代理的工作流程通常非常複雜,涉及多個步驟和決策點。這些複雜的工作流程難以建模,並需要更複雜的評估方法。代理可能需要與多個大型語言模型(LLM)協作,這使得性能和成本的確定變得更加困難。隨著工作流程的規模和複雜性增加,錯誤風險也隨之增長。

在這種情況下,Galileo 的 Agentic Evaluations 平台提供了一個完整的生命周期框架,用於系統級和逐步評估。該平台通過追蹤和簡單的可視化幫助開發者快速找出低效和錯誤,從而提高工作流程的效率和準確性。這些功能使得開發者能夠更好地理解和優化 AI 代理的行為。

多模型協作的挑戰

AI 代理通常需要與多個 LLM 協作,這增加了系統的複雜性。不同的模型可能會對同一任務產生不同的解決方案,這使得性能和成本的管理變得更加困難。開發者需要確保不同模型之間的協作是高效且無錯誤的,這需要更高級的評估技術。

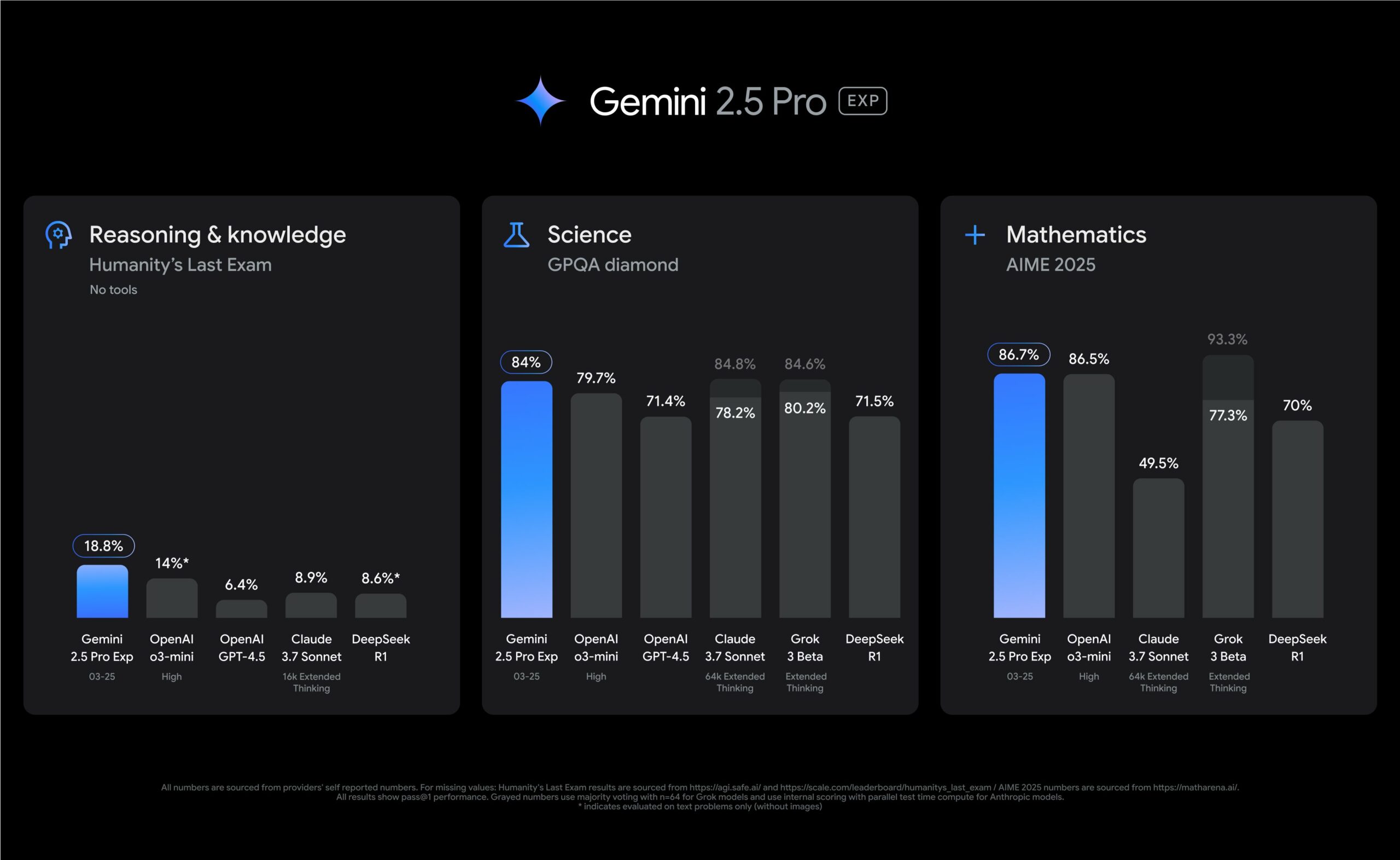

Galileo 的 Agentic Evaluations 平台使用了一套專有的 LLM-as-a-Judge 指標,這是一種使用 LLM 來檢查和裁決任務的評估技術,專門針對構建代理的開發者。這些指標的準確性在 93% 到 97% 之間,為開發者提供了可靠的評估工具。

Source: [Galileo unleashes platform for evaluating AI agents] from SiliconANGLE

總結來說,AI 代理的複雜性和挑戰需要開發者採用新的方法和工具來應對。Galileo 的 Agentic Evaluations 平台提供了強大的支持,幫助開發者更好地理解和管理 AI 代理的行為。隨著技術的進步,這些平台將在提高工作流程效率和準確性方面發揮關鍵作用。

Galileo 的 Agentic Evaluations 平台

在人工智慧(AI)技術的快速發展中,Galileo Technologies Inc. 推出的 Agentic Evaluations 平台成為了評估 AI 代理性能的重要工具。這一平台專注於由大型語言模型(LLM)驅動的 AI 代理,提供了一個完整的生命周期框架,幫助開發者在系統級和逐步評估中獲得更高的效率和準確性。

平台的核心功能

Galileo 的 Agentic Evaluations 平台提供了一個從輸入到完成的多步驟代理過程的全景視圖。這一功能使得開發者能夠追蹤代理的每一步行動,並通過簡單的可視化工具快速找出低效和錯誤。這種全方位的視角對於理解和優化 AI 代理的行為至關重要。

平台使用了一套專有的 LLM-as-a-Judge 指標,這是一種利用 LLM 來檢查和裁決任務的評估技術,專門針對構建代理的開發者。這些指標包括:

| 指標 | 描述 |

|---|---|

| 工具選擇準確性 | 評估 LLM 規劃者是否選擇了正確的工具和參數 |

| 工具錯誤評估 | 評估單個工具的錯誤 |

| 進度追蹤 | 反映向最終目標的進展 |

| 行動對齊 | 評估最終行動與代理原始指令的對齊 |

這些指標的準確性在 93% 到 97% 之間,為開發者提供了可靠的評估工具。

多層次性能測量

Agentic Evaluations 平台的性能測量基於專有的、研究驅動的多層次指標。開發者可以選擇參與規劃的 LLM,並評估單個任務中的錯誤。這種靈活性使得開發者能夠根據具體需求調整評估過程,從而提高工作流程的效率。

平台還提供了會話和跨度的成本、延遲和錯誤的聚合追蹤,這有助於成本和延遲的測量。警報和儀表板功能則幫助識別系統性問題,從而持續改進,例如工具調用失敗或行動與指令不一致。

Source: [Galileo unleashes platform for evaluating AI agents] from SiliconANGLE

支持開源框架

Galileo 的 Agentic Evaluations 平台支持流行的開源 AI 框架 LangGraph 和 CrewAI。這一特性使得開發者能夠在熟悉的環境中工作,並利用現有的工具和資源來優化 AI 代理的性能。

這些開源框架的支持不僅提高了平台的靈活性,還促進了社區的合作和創新。開發者可以共享他們的經驗和最佳實踐,從而推動 AI 技術的進一步發展。

結論

Galileo 的 Agentic Evaluations 平台為開發者提供了強大的工具來應對 AI 代理的複雜性和挑戰。隨著技術的進步,這些平台將在提高工作流程效率和準確性方面發揮關鍵作用。對於那些希望在 AI 領域保持競爭力的企業來說,採用這些評估工具將是至關重要的。您是否準備好迎接 AI 代理的未來?

Galileo unleashes platform for evaluating AI agents

平台的性能與支持

在當今快速發展的人工智慧(AI)領域,Galileo Technologies Inc. 的 Agentic Evaluations 平台以其卓越的性能測量和支持功能,成為開發者不可或缺的工具。這一平台不僅提供了多層次的性能測量指標,還支持多種開源框架,為開發者提供了靈活且高效的開發環境。

多層次性能測量

Agentic Evaluations 平台的性能測量基於專有的、研究驅動的多層次指標,這些指標能夠精確地評估 AI 代理在不同任務中的表現。開發者可以根據具體需求選擇參與規劃的 LLM,並評估單個任務中的錯誤。這種靈活性使得開發者能夠根據具體需求調整評估過程,從而提高工作流程的效率。

平台還提供了會話和跨度的成本、延遲和錯誤的聚合追蹤,這有助於成本和延遲的測量。警報和儀表板功能則幫助識別系統性問題,從而持續改進,例如工具調用失敗或行動與指令不一致。

Source: [Galileo unleashes platform for evaluating AI agents] from SiliconANGLE

支持開源框架

Galileo 的 Agentic Evaluations 平台支持流行的開源 AI 框架 LangGraph 和 CrewAI。這一特性使得開發者能夠在熟悉的環境中工作,並利用現有的工具和資源來優化 AI 代理的性能。這些開源框架的支持不僅提高了平台的靈活性,還促進了社區的合作和創新。開發者可以共享他們的經驗和最佳實踐,從而推動 AI 技術的進一步發展。

平台的持續改進

Agentic Evaluations 平台的設計考慮到了持續改進的需求。通過警報和儀表板,開發者可以快速識別和解決系統性問題,這對於保持高效的工作流程至關重要。這些工具能夠幫助開發者及時發現問題,例如工具調用失敗或行動與指令不一致,從而在問題擴大之前進行修正。

Source: [Galileo unleashes platform for evaluating AI agents] from SiliconANGLE

結論

Galileo 的 Agentic Evaluations 平台為開發者提供了強大的工具來應對 AI 代理的複雜性和挑戰。隨著技術的進步,這些平台將在提高工作流程效率和準確性方面發揮關鍵作用。對於那些希望在 AI 領域保持競爭力的企業來說,採用這些評估工具將是至關重要的。您是否準備好迎接 AI 代理的未來?

Galileo unleashes platform for evaluating AI agents

結論

在當今快速變化的科技環境中,AI 代理評估平台如 Galileo 的 Agentic Evaluations,為開發者提供了強大的工具來應對 AI 代理的複雜性和挑戰。這些平台不僅提高了工作流程的效率和準確性,還為企業在 AI 領域保持競爭力提供了關鍵支持。

提高工作流程效率

Galileo 的 Agentic Evaluations 平台通過其多層次的性能測量指標,幫助開發者精確地評估 AI 代理在不同任務中的表現。這些指標不僅能夠識別系統性問題,還能夠提供即時的警報和儀表板,幫助開發者快速解決問題。這種即時反饋機制對於保持高效的工作流程至關重要,特別是在面對複雜的代理工作流程時。

Source: [Galileo unleashes platform for evaluating AI agents] from SiliconANGLE

促進企業競爭力

隨著技術的進步,AI 代理的應用範圍和複雜性不斷增加。根據 Gartner 的預測,到 2028 年,33% 的企業軟體應用將包含代理 AI。這意味著企業需要採用先進的評估工具來保持競爭力。Galileo 的平台不僅支持流行的開源 AI 框架,還提供了靈活的開發環境,這使得企業能夠快速適應市場變化,並在 AI 領域中保持領先地位。

行動導向的未來展望

對於那些希望在 AI 領域保持競爭力的企業來說,採用這些評估工具將是至關重要的。Galileo 的 Agentic Evaluations 平台不僅提供了強大的技術支持,還為企業提供了面向未來的行動指南。隨著 AI 技術的進一步發展,這些平台將在提高工作流程效率和準確性方面發揮關鍵作用。您是否準備好迎接 AI 代理的未來?

Source: [Galileo unleashes platform for evaluating AI agents] from SiliconANGLE

在這個充滿挑戰和機遇的時代,Galileo 的 Agentic Evaluations 平台為開發者和企業提供了必要的工具和支持,幫助他們在 AI 領域中取得成功。通過採用這些先進的評估技術,企業可以確保其 AI 代理的性能和效率,從而在競爭激烈的市場中脫穎而出。

Galileo unleashes platform for evaluating AI agents