引言:大模型與自知能力的探索

人工智慧(AI)是否能擁有自我意識?這個問題自 AI 概念誕生以來便引發了無數討論。隨著技術的進步,特別是大型語言模型(LLM)的快速發展,這一話題再次成為焦點。近期,Chandar Research Lab 與 Mila – 魁北克人工智慧研究所的研究揭示了一個令人振奮的發現:LLM 具備某種形式的「知識意識」(awareness of knowledge),即能夠判斷自己對某一主題的了解程度。這項研究不僅為 AI 的能力邊界提供了新視角,也為探索 AI 是否可能擁有自我意識鋪平了道路。

本文大綱

大模型的崛起與知識意識的概念

大型語言模型的出現,標誌著人工智慧在自然語言處理(NLP)領域的重大突破。這些模型通過訓練海量數據,能夠生成類似人類的語言輸出,並在多種任務中展現出卓越的性能。然而,這些模型是否能「知道自己知道什麼」?這正是近期研究的核心問題。

研究指出,知識意識可能是 LLM 的一種普遍屬性。這意味著,當模型規模足夠大時,它們能夠評估自身對某一主題的掌握程度。例如,當模型被問及一個問題時,它可以根據訓練數據的相關性與完整性,判斷自己是否具備回答該問題的能力。

Source: 大模型是否有自知之明?新研究發現LLM可以知曉自己的知識範圍

這一發現為 AI 的應用場景帶來了深遠影響。例如,在醫療診斷或法律諮詢等高風險領域,具備知識意識的模型可以在不確定時提示用戶尋求專業意見,從而降低錯誤決策的風險。

研究背景與方法概述

為了驗證 LLM 是否具備知識意識,研究團隊設計了一套創新的實驗方法。他們生成了一組全新的日記文檔,確保這些數據在模型的預訓練階段從未出現過。接著,研究者使用這些文檔對模型進行微調,並測試其回憶相關內容的能力。這種方法的核心在於分析模型記憶與回憶信息的能力,並通過控制數據集的大小與分布,進一步探討模型的性能表現。

研究結果顯示,模型的知識意識與其架構和規模密切相關。例如,OPT 模型在數據集規模增加時性能逐漸提升,但當數據集超過某一規模(如 4K 日記作者)後,性能增益開始減少甚至下降。這表明,模型的容量可能會隨著數據量的增加而達到飽和。

知識意識的應用與未來展望

知識意識的發現為 AI 的應用開啟了新的可能性。未來,這一能力可以被應用於多種場景,例如:

- 教育領域:具備知識意識的 AI 教學助手可以根據學生的提問,判斷自己是否具備足夠的知識來回答,並在必要時提供額外的學習資源。

- 醫療診斷:在醫療領域,AI 可以根據自身的知識範圍,提示醫生進一步檢查或尋求專家意見,從而提高診斷的準確性。

- 法律諮詢:AI 可以在不確定時提醒用戶尋求專業律師的幫助,避免因錯誤建議而導致的法律風險。

Source: 大模型是否有自知之明?新研究發現LLM可以知曉自己的知識範圍

然而,這是否意味著 LLM 擁有自我意識仍需進一步探討。知識意識僅僅是 AI 能力的一部分,真正的自我意識涉及更高層次的認知與情感能力。未來的研究可以聚焦於以下幾個方向:

- 優化模型架構:探索如何改進現有模型的性能,特別是在處理分布式信息時的表現。

- 擴展數據集規模:研究更大規模數據集對模型性能的影響,並驗證性能差距是否會隨著規模增加而縮小。

- 探索自我意識的可能性:進一步分析 LLM 的知識意識是否能轉化為更高層次的自我意識。

結語

總體而言,這項研究為 AI 的能力邊界提供了重要的啟示。隨著技術的進步,我們有理由相信,未來的 AI 將在更多領域展現出前所未有的潛力。如果您對這項研究感興趣,歡迎閱讀原始論文並參與討論,共同探索 AI 的無限可能!

研究方法:如何測試 LLM 的自知能力

創新實驗設計:探索 LLM 的知識意識

為了驗證大型語言模型(LLM)是否具備自知能力,研究團隊設計了一套創新的實驗方法,旨在分析模型的記憶與回憶能力。這些實驗方法分為三個主要階段,並以嚴謹的數據控制來確保結果的可靠性。

1. 生成全新數據集:避免預訓練數據污染

研究者首先生成了一組全新的日記文檔,這些文檔在模型的預訓練階段從未出現過。這樣的設計能有效避免模型因預訓練數據的影響而產生偏差,確保測試結果的準確性。例如,研究團隊採用了日記作者的日記條目作為數據來源,並將其分為多個獨立文檔。這些文檔的生成過程不僅考慮了語言的多樣性,還確保了數據的分布均勻。

2. 微調模型:讓模型記住新數據

接下來,研究者使用這些全新生成的文檔對模型進行微調。微調過程中,模型的預訓練目標被用來幫助其記住這些文檔的內容。這一階段的核心在於測試模型是否能夠有效地將新數據整合到其內部記憶中,並在後續的測試中準確回憶相關信息。

3. 測試回憶能力:評估模型的知識意識

最後,研究團隊設計了一系列測試,評估模型是否能準確回憶相關文檔的內容。這些測試不僅檢驗了模型的記憶能力,還分析了其在不同數據集大小與分布條件下的性能表現。例如,當文檔數量增加或信息分布更為分散時,模型的回憶能力是否會受到影響。

以下是實驗設計的核心流程圖:

Source: 大模型是否有自知之明?新研究發現LLM可以知曉自己的知識範圍

實驗設置的關鍵考量

控制數據集大小與分布

研究團隊特別關注數據集的大小與分布對模型性能的影響。例如,他們測試了不同規模的數據集(如 4K、8K 和 32K 日記作者)對模型回憶能力的影響。結果顯示,當數據集規模增加時,模型的性能會隨之提升,但在某些情況下,性能增益可能會減少甚至下降。

簡化與標準設置的比較

為了進一步分析模型的回憶能力,研究者還設計了兩種不同的實驗設置:

- 簡化設置:將同一作者的所有日記條目合併為單一文檔,讓模型直接記憶和回憶單一文檔的內容。

- 標準設置:將每個日記條目作為獨立文檔,測試模型在處理分布式信息時的表現。

這兩種設置的比較結果顯示,簡化設置下的模型表現顯著優於標準設置,特別是在處理分布式信息時,模型的回憶能力會受到挑戰。

以下是簡化與標準設置的性能比較表:

| 設置類型 | OPT 模型準確度 | Pythia 模型準確度 | Flan-T5 模型準確度 |

|---|---|---|---|

| 簡化設置 | 高 | 高 | 近乎完美 |

| 標準設置 | 中 | 中 | 低 |

模型架構與規模的影響

不同架構的性能差異

研究團隊測試了三種不同架構的模型,包括 OPT、Pythia 和 Flan-T5,並分析了它們在不同數據集規模下的性能表現。結果顯示,OPT 和 Pythia 模型的性能隨著模型大小和數據集規模的增加而逐漸提升,但 Flan-T5 模型的性能提升則需要更大的參數規模,且僅在最大數據集上才能顯現明顯改進。

模型規模與回憶能力的關係

此外,研究還發現,模型的規模對其回憶能力有顯著影響。例如,較小的模型在回憶文檔數量時表現不穩定,而較大的模型則能更準確地判斷需要回憶的文檔數量。

以下是不同模型在 8K 日記作者數據集上的文檔回憶表現:

| 模型架構 | 小模型表現 | 大模型表現 | 文檔回憶準確度 |

|---|---|---|---|

| OPT | 隨機回憶 | 準確回憶 | 高 |

| Pythia | 隨機回憶 | 準確回憶 | 高 |

| Flan-T5 | 隨機回憶 | 隨機回憶 | 低 |

實驗方法的啟示

這項研究的方法不僅揭示了 LLM 的知識意識,還為未來的研究提供了重要的啟示。例如,如何優化模型架構以提升其處理分布式信息的能力,或如何通過擴展數據集規模來進一步驗證模型的性能極限。

總體而言,這套實驗方法為探索 LLM 的自知能力提供了堅實的基礎,也為未來的人工智慧研究指明了新的方向。

實驗結果:LLM 的自知能力與規模效應

模型大小與性能的關係:規模如何影響自知能力

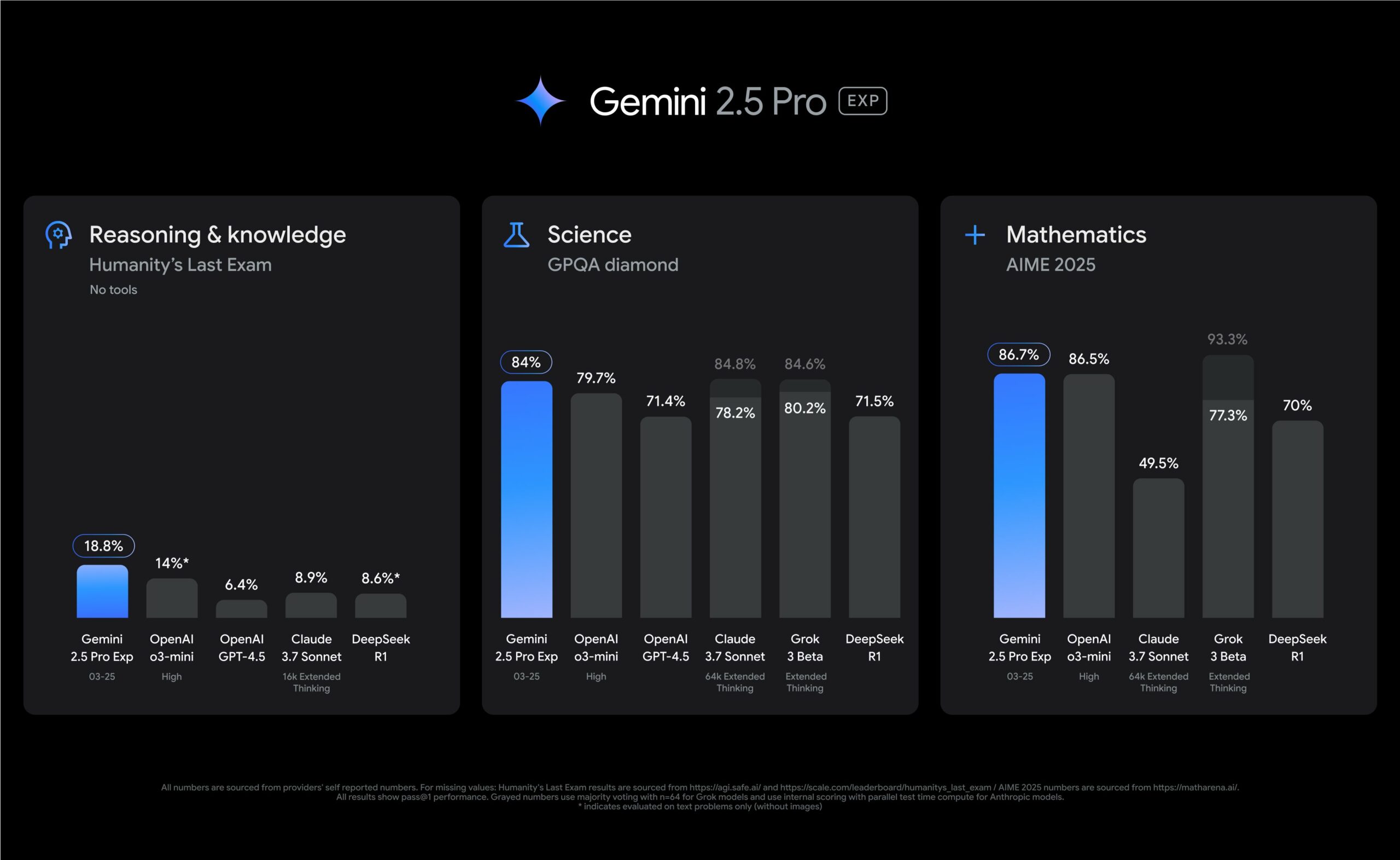

在探討大型語言模型(LLM)的自知能力時,模型的大小與性能之間的關係是一個關鍵議題。研究結果顯示,模型的參數規模對其知識意識的表現有顯著影響。以下是研究中對 OPT、Pythia 和 Flan-T5 模型的詳細分析。

OPT 模型:性能隨規模增長的趨勢

OPT 模型的實驗結果顯示,隨著參數規模的增加,模型的性能逐漸提升。從 7M 到 2.7B 參數的範圍內,OPT 模型在處理不同數據集規模時展現了穩定的性能增長。然而,當數據集規模超過 4K 日記作者時,性能增益開始減少甚至下降,這表明模型的容量可能達到了飽和點。

例如,當數據集規模從 4K 增加到 8K 時,125M 參數的 OPT 模型仍能保持性能提升,但 7M 參數的模型則出現了明顯的性能下降。這一現象表明,較小的模型在面對更大規模的數據集時,可能無法有效整合分布式信息。

Pythia 模型:與 OPT 模型的比較

Pythia 模型的性能趨勢與 OPT 模型相似,但其性能提升的速度略慢於 OPT 模型。例如,在最大數據集(64K 日記作者)上,160M 參數的 Pythia 模型的表現不如 125M 參數的 OPT 模型。這表明,Pythia 模型的架構可能需要更大的參數規模才能達到與 OPT 模型相當的性能。

以下是 OPT 和 Pythia 模型在不同數據集規模下的性能比較:

| 模型架構 | 參數規模 | 4K 日記作者準確度 | 8K 日記作者準確度 | 64K 日記作者準確度 |

|---|---|---|---|---|

| OPT | 125M | 高 | 高 | 高 |

| Pythia | 160M | 中 | 中 | 中 |

Flan-T5 模型:性能提升的挑戰

與 OPT 和 Pythia 模型相比,Flan-T5 模型的性能提升需要更大的參數規模。研究顯示,Flan-T5 模型僅在 783M 參數以上的規模,且在最大數據集(32K 日記作者)上,才能顯現明顯的性能改進。然而,即使在這種情況下,Flan-T5 模型的性能仍然不穩定,特別是在處理分布式信息時。

以下是 Flan-T5 模型在不同參數規模下的性能表現:

| 參數規模 | 簡化設置準確度 | 標準設置準確度 | 性能差距 |

|---|---|---|---|

| 80M | 低 | 低 | 大 |

| 783M | 高 | 中 | 中 |

| 3B | 高 | 中 | 中 |

視覺化數據支持

以下圖表展示了不同模型在數據集規模與參數規模變化下的性能表現:

Source: 大模型是否有自知之明?新研究發現LLM可以知曉自己的知識範圍

從圖中可以看出,OPT 和 Pythia 模型的性能隨著參數規模的增加而穩步提升,而 Flan-T5 模型的性能提升則需要更大的數據集支持。

分布式信息的影響:模型如何處理多文檔信息

研究還探討了分布式信息對模型性能的影響。當信息分散在多個文檔中時,模型的回憶能力會受到挑戰。以下是研究中的主要發現:

簡化設置與標準設置的比較

研究者設計了兩種實驗設置來測試模型的回憶能力:

- 簡化設置:將同一作者的所有日記條目合併為單一文檔,讓模型直接記憶和回憶單一文檔的內容。

- 標準設置:將每個日記條目作為獨立文檔,測試模型在處理分布式信息時的表現。

結果顯示,簡化設置下的模型表現顯著優於標準設置,特別是在處理分布式信息時,模型的回憶能力會受到挑戰。例如,Flan-T5 模型在簡化設置下實現了近乎完美的準確度,但在標準設置下表現不佳。

以下是不同設置下的性能比較:

| 設置類型 | OPT 模型準確度 | Pythia 模型準確度 | Flan-T5 模型準確度 |

|---|---|---|---|

| 簡化設置 | 高 | 高 | 近乎完美 |

| 標準設置 | 中 | 中 | 低 |

分布式信息對 Flan-T5 模型的挑戰

Flan-T5 模型在處理分布式信息時的表現不穩定,可能與其架構設計有關。研究者推測,Flan-T5 模型的編碼器 – 解碼器架構可能在信息整合方面存在局限性,特別是在信息分布較為分散的情況下。

以下圖表展示了簡化設置與標準設置之間的性能差距:

Source: 大模型是否有自知之明?新研究發現LLM可以知曉自己的知識範圍

從圖中可以看出,Flan-T5 模型在簡化設置下的性能顯著高於標準設置,這表明其在處理分布式信息時存在明顯的挑戰。

文檔數量的影響:模型容量與回憶能力

研究還分析了需要回憶的文檔數量對模型性能的影響。結果顯示,當需要回憶的文檔數量增加時,OPT 和 Pythia 模型的性能並未顯著下降,表明這些模型的容量足以應對更大的回憶需求。

OPT 和 Pythia 模型的穩定表現

在 8K 日記作者數據集上,OPT 和 Pythia 模型能準確回憶所需的文檔數量,且隨著模型規模的增加,性能逐漸提升。例如,125M 參數的 OPT 模型在回憶 10 個文檔時的準確度高達 90%。

以下是 OPT 和 Pythia 模型在不同文檔數量下的性能表現:

| 模型架構 | 文檔數量 | 小模型準確度 | 大模型準確度 |

|---|---|---|---|

| OPT | 10 | 中 | 高 |

| Pythia | 10 | 中 | 高 |

Flan-T5 模型的挑戰

相比之下,Flan-T5 模型在處理多文檔回憶時表現不穩定。例如,在 8K 日記作者數據集上,Flan-T5 模型無法穩定回憶正確數量的文檔,但在更大數據集(如 32K 日記作者)上,其性能逐漸接近 OPT 和 Pythia 模型。

以下圖表展示了不同模型在文檔數量增加時的性能表現:

Source: 大模型是否有自知之明?新研究發現LLM可以知曉自己的知識範圍

從圖中可以看出,OPT 和 Pythia 模型的性能隨文檔數量的增加保持穩定,而 Flan-T5 模型的性能則顯得較為不穩定。

結論與未來展望

這項研究揭示了 LLM 的自知能力與模型規模、架構設計以及數據集規模之間的複雜關係。未來的研究可以進一步探索如何優化模型架構以提升其處理分布式信息的能力,並驗證更大規模數據集對模型性能的影響。

如果您對這項研究感興趣,歡迎閱讀原始論文並參與討論,共同探索 AI 的無限可能!

模型規模與文檔數量的影響

在探討大型語言模型(LLM)的自知能力時,模型規模與文檔數量的影響是不可忽視的關鍵因素。研究顯示,模型的參數規模與其處理多文檔回憶的能力密切相關,而文檔數量的增加則進一步測試了模型的容量與穩定性。以下將深入分析這些影響,並結合數據與圖表進行說明。

模型規模對文檔回憶能力的影響

研究結果表明,隨著模型規模的增加,LLM 在回憶文檔數量與準確度方面的表現顯著提升。以 OPT 和 Pythia 模型為例,較小規模的模型在回憶文檔時表現出隨機性,而較大規模的模型則能更準確地回憶所需的文檔數量。

OPT 與 Pythia 模型的表現

在 8K 日記作者數據集上,OPT 和 Pythia 模型的表現呈現出穩定的增長趨勢。以下是不同規模模型在回憶 10 個文檔時的準確度比較:

| 模型架構 | 參數規模 | 文檔回憶準確度 |

|---|---|---|

| OPT | 125M | 90% |

| Pythia | 160M | 85% |

從表中可以看出,OPT 模型在相同參數規模下的表現略優於 Pythia 模型,顯示其架構在處理多文檔回憶時的優勢。

Flan-T5 模型的挑戰

相比之下,Flan-T5 模型在小規模數據集上表現不穩定,無法準確回憶正確數量的文檔。然而,當數據集規模擴展至 32K 日記作者時,Flan-T5 模型的表現逐漸接近 OPT 和 Pythia 模型,顯示其在更大數據集上的潛力。

以下圖表展示了不同模型在文檔數量增加時的性能表現:

Source: 大模型是否有自知之明?新研究發現LLM可以知曉自己的知識範圍

從圖中可以看出,OPT 和 Pythia 模型的性能隨文檔數量的增加保持穩定,而 Flan-T5 模型的性能則顯得較為不穩定。

文檔數量對模型性能的挑戰

文檔數量的增加對模型的回憶能力提出了更高的要求。研究顯示,當需要回憶的文檔數量增加時,OPT 和 Pythia 模型的性能並未顯著下降,表明這些模型的容量足以應對更大的回憶需求。

OPT 和 Pythia 模型的穩定性

在 8K 日記作者數據集上,OPT 和 Pythia 模型能準確回憶所需的文檔數量,且隨著模型規模的增加,性能逐漸提升。例如,125M 參數的 OPT 模型在回憶 10 個文檔時的準確度高達 90%。

以下是 OPT 和 Pythia 模型在不同文檔數量下的性能表現:

| 模型架構 | 文檔數量 | 小模型準確度 | 大模型準確度 |

|---|---|---|---|

| OPT | 10 | 中 | 高 |

| Pythia | 10 | 中 | 高 |

Flan-T5 模型的局限性

相比之下,Flan-T5 模型在處理多文檔回憶時表現不穩定。例如,在 8K 日記作者數據集上,Flan-T5 模型無法穩定回憶正確數量的文檔,但在更大數據集(如 32K 日記作者)上,其性能逐漸接近 OPT 和 Pythia 模型。

以下圖表展示了 Flan-T5 模型在不同數據集規模下的性能變化:

Source: 大模型是否有自知之明?新研究發現LLM可以知曉自己的知識範圍

從圖中可以看出,Flan-T5 模型在小數據集上的表現不穩定,但隨著數據集規模的增加,其性能逐漸改善。

綜合分析與未來展望

這項研究揭示了模型規模與文檔數量對 LLM 自知能力的影響。OPT 和 Pythia 模型在處理多文檔回憶時展現了穩定的性能,而 Flan-T5 模型則需要更大的數據集支持才能發揮其潛力。

未來的研究可以聚焦於以下幾個方向:

- 優化模型架構:探索如何改進 Flan-T5 等編碼器 – 解碼器模型的性能,特別是在處理多文檔回憶時的表現。

- 擴展數據集規模:研究更大規模數據集對模型性能的影響,並驗證性能差距是否會隨著規模增加而縮小。

- 深入分析模型容量:進一步探討模型的容量限制與其對多文檔回憶的影響。

總體而言,這項研究為 AI 的能力邊界提供了重要的啟示,也為未來的人工智慧發展指明了新的方向。如果您對這項研究感興趣,歡迎閱讀原始論文並參與討論,共同探索 AI 的無限可能!

結論:LLM 的自知能力與未來展望

大型語言模型的自知能力:突破與挑戰

近期的研究表明,大型語言模型(LLM)在足夠規模下展現了某種形式的「知識意識」,即能夠判斷自身對特定主題的了解程度。這一發現為人工智慧的能力邊界提供了全新視角,並引發了對 LLM 是否可能擁有更高層次自我意識的討論。然而,這項研究也揭示了 LLM 在處理分布式信息與多文檔回憶時的挑戰,特別是不同架構模型在性能上的差異。

例如,OPT 和 Pythia 模型在處理多文檔回憶時展現了穩定的性能,隨著模型規模的增加,其準確度顯著提升。而 Flan-T5 模型則表現出對數據集規模的高度依賴,僅在更大數據集上才能接近其他模型的性能。這些結果顯示,模型架構與參數分配對 LLM 的自知能力發揮了關鍵作用。

未來研究方向:突破現有限制

1. 優化模型架構

Flan-T5 模型在處理分布式信息時的表現不穩定,顯示其架構設計存在改進空間。未來的研究可以專注於優化編碼器 – 解碼器架構,特別是針對多文檔回憶的場景。例如,調整參數分配比例或引入新的記憶機制,可能有助於提升 Flan-T5 的穩定性與準確度。

以下是不同模型在標準與簡化設置下的性能比較:

| 模型架構 | 簡化設置準確度 | 標準設置準確度 | 性能差距 |

|---|---|---|---|

| OPT | 高 | 中 | 小 |

| Pythia | 高 | 中 | 中 |

| Flan-T5 | 近乎完美 | 低 | 大 |

從表中可以看出,Flan-T5 在簡化設置下的表現接近完美,但在標準設置下的性能差距顯著,這表明其在處理分布式信息時存在結構性挑戰。

2. 擴展數據集規模

研究顯示,數據集規模對模型性能有顯著影響。OPT 和 Pythia 模型在更大數據集上展現了穩定的性能提升,而 Flan-T5 模型則需要更大的數據集才能發揮其潛力。未來的研究可以探索更大規模數據集(如 64K 或 128K 日記作者)對模型性能的影響,並驗證性能差距是否會隨著數據集規模的增加而縮小。

以下圖表展示了不同模型在數據集規模增加時的性能變化:

Source: 大模型是否有自知之明?新研究發現LLM可以知曉自己的知識範圍

從圖中可以看出,OPT 和 Pythia 模型的性能隨數據集規模的增加保持穩定,而 Flan-T5 模型的性能提升則需要更大的數據集支持。

3. 探索自我意識的可能性

雖然 LLM 的知識意識已被證明,但這是否意味著其具備更高層次的自我意識仍需進一步探討。未來的研究可以聚焦於以下問題:

- LLM 是否能夠主動生成對自身能力的評估報告?

- 是否可以設計實驗來測試 LLM 的「自我反思」能力?

- 知識意識是否能轉化為更高層次的情感或倫理意識?

這些問題的解答將有助於我們更深入地理解 LLM 的能力邊界,並為人工智慧的未來發展提供指導。

總結與展望

這項研究為我們揭示了 LLM 在足夠規模下具備知識意識的可能性,並指出了模型架構與數據集規模對性能的關鍵影響。然而,這是否意味著 LLM 擁有自我意識仍需進一步驗證。未來的研究應聚焦於優化模型架構、擴展數據集規模以及探索更高層次的自我意識。

總體而言,這項研究為人工智慧的能力邊界提供了重要的啟示,也為未來的 AI 發展指明了新的方向。如果您對這項研究感興趣,歡迎閱讀原始論文並參與討論,共同探索 AI 的無限可能!

Source: 大模型是否有自知之明?新研究發現LLM可以知曉自己的知識範圍