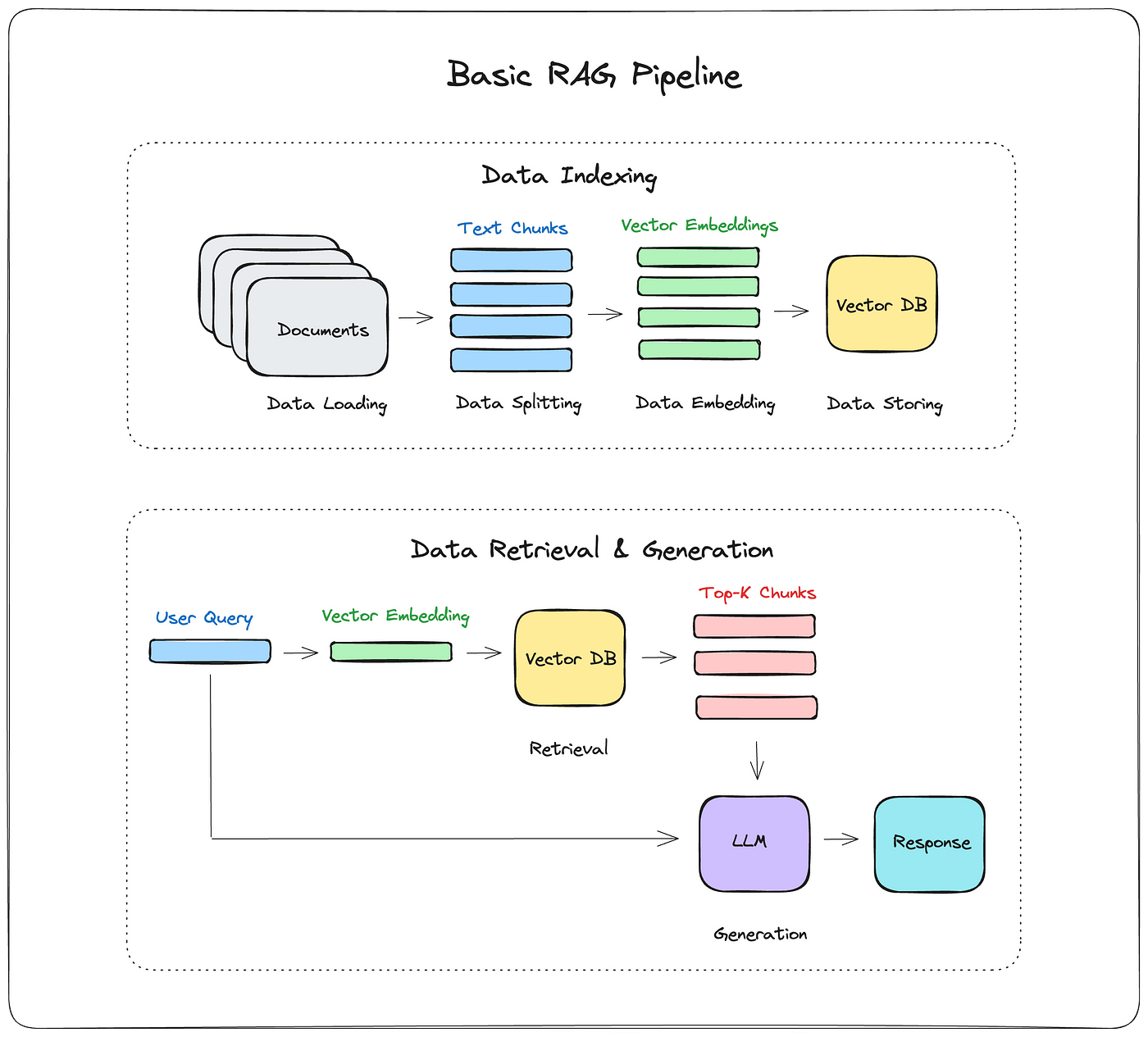

RAG 技術概述 RAG(Retrieval Augmented Generation,檢索增強生成)是一種結合了大規模 …

RAG技術終極入門:基礎架構與工作原理詳解

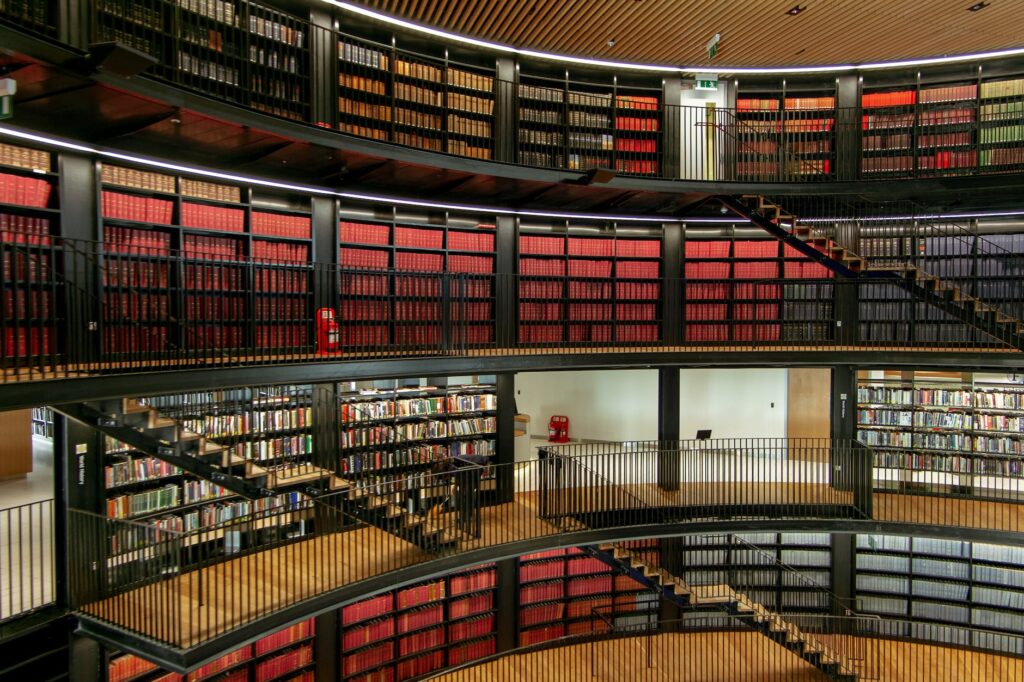

AI研究員、挖掘資料價值的現代探員

RAG 技術概述 RAG(Retrieval Augmented Generation,檢索增強生成)是一種結合了大規模 …

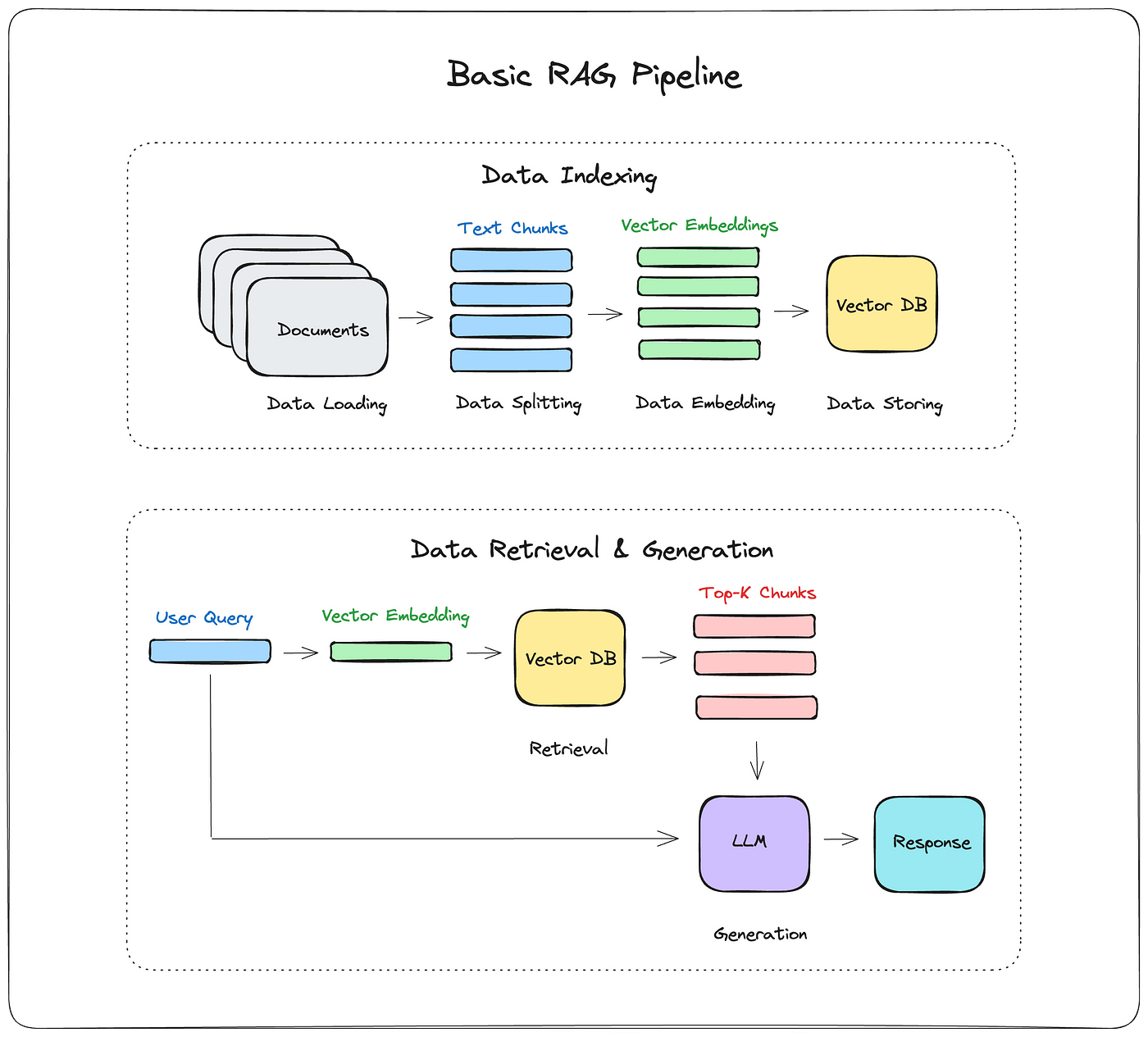

隨著 AI 技術的不斷進步,企業正越來越多地尋求將大型語言模型(LLM)整合到其業務流程中。這些強大的工具提供了無限的可 …

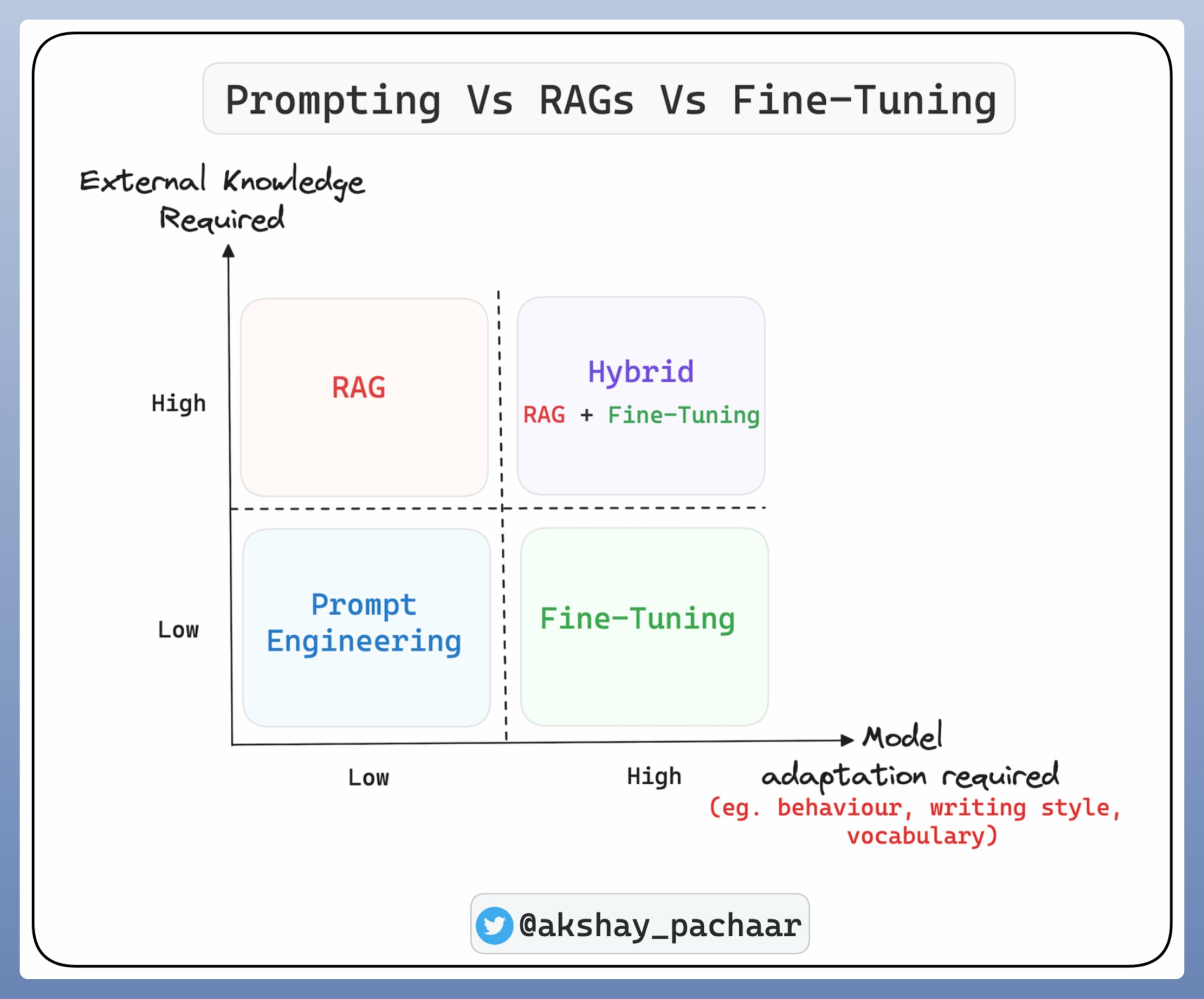

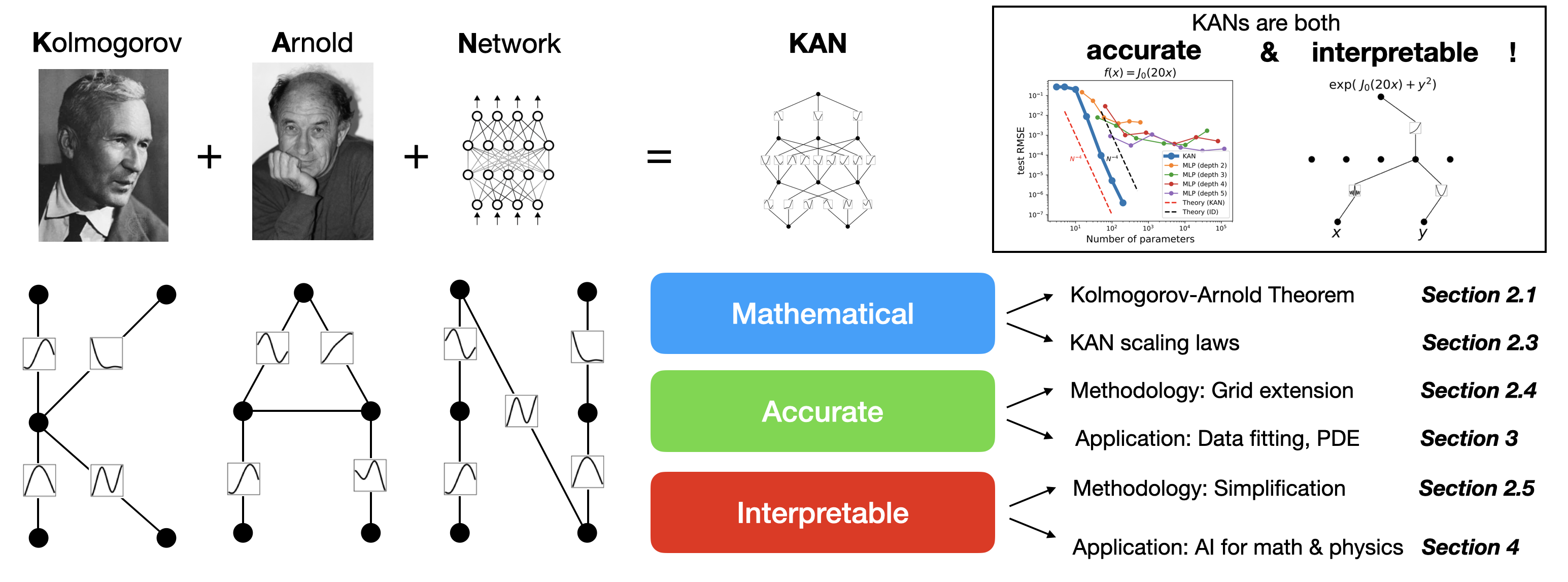

近年來,深度學習技術在多個領域實現了突破性進展,從語言處理到影像識別,無不體現了其強大的學習能力。而在這一進步的核心,多 …

在本教學中,我們將學習如何使用 Docker 快速部署 Neo4j 社群版資料庫。我們將採用 docker-compos …

抽取金融事件能幫助用戶獲得競爭對手的戰略,預測股票市場做出正確的投資決策。舉例來說,股權凍結事件將對公司產生不利影響,股票持有者應迅速判斷避險

今天這篇要教大家如何使用 OpenAI Finetune API 微調出自己的模型。 想必大家都學會使用網頁版 Chat …

Finetune 語言模型所需要的 GPU memory 比較多,往往會需要我們能夠利用到多顆 GPU 的資源。今天這篇文章會說明 DataParallel 和 DistributedDataParallel + DistributedSampler 兩種進行模型分散式訓練的方式。

這篇文章紀錄我串接非官方 ChatGPT API 「試圖」取得 NLP 資訊抽取任務標籤的過程。結論是…

以下整理 套件開發協作時常遇到與用到的 Git 指令: SSH Key 與 HTTPS 的差別 其中 <repo_ …

(一)主題 從天貓 TMall 用戶網站行為紀錄,透過視覺化整理: 基本的資料分布 比較不同用戶分組的行為分布差異 …