進階微調 Mistral-7B 模型的方法:直接偏好優化

預訓練的大型語言模型(LLM)只能進行下一個詞預測,使得它們無法回答問題。這就是為什麼這些基礎模型之後需要通過指令和答案的配對進行精調,以充當有用的助手。然而,這個過程仍可能存在缺陷:精調後的 LLM 可能會有偏見、有毒害、有害等。這就是人類反饋中的強化學習(RLHF)發揮作用的地方。

隨著 AI 技術的飛速發展,語言模型(LLM)在近幾年取得了…

引言 在 AI 界的一場沉寂之後,阿里巴巴集團最近發布了一款…

在人工智慧(AI)的急速發展下,企業對於更高效、更智慧的語言…

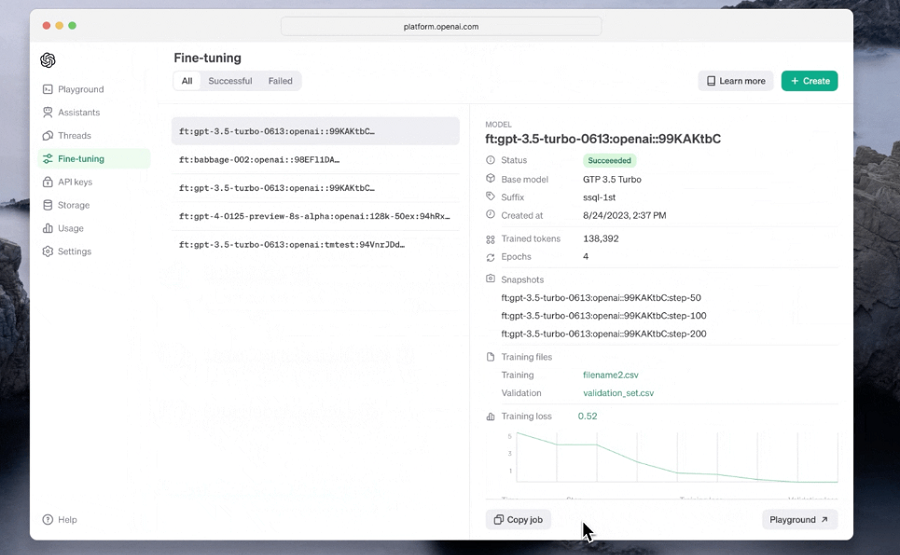

引言 在 AI 領域,OpenAI 一直是創新和突破的代名詞…

預訓練的大型語言模型(LLM)只能進行下一個詞預測,使得它們無法回答問題。這就是為什麼這些基礎模型之後需要通過指令和答案的配對進行精調,以充當有用的助手。然而,這個過程仍可能存在缺陷:精調後的 LLM 可能會有偏見、有毒害、有害等。這就是人類反饋中的強化學習(RLHF)發揮作用的地方。